2025 a apporté une étrange convergence : les essais universitaires et les coloscopies ont tous deux démontré ce qui peut se passer lorsque l'intelligence artificielle (IA) dirige le travail.

Tout d'abord, les données du collège : Une équipe du MIT a rapporté en juin que lorsque les étudiants utilisaient ChatGPT pour écrire des essais, ils contractaient une dette cognitive et "les utilisateurs étaient constamment sous-performants aux niveaux neuronal, linguistique et comportemental", ce qui a entraîné une "diminution probable des compétences d'apprentissage".

Puis est venu l'écho clinique. Dans une étude prospective de Pologne publiée le mois dernier dans The Lancet Gastroenterology and Hepatology, les gastro-entérologues qui s'étaient habitués à un système de coloscopie assisté par l'IA semblaient être environ 20 % moins nombreux pour repérer les polypes et autres anomalies lorsqu'ils travaillaient par la suite sur eux-mêmes. En seulement 6 mois, les auteurs ont observé que les cliniciens sont devenus "moins motivés, moins concentrés et moins responsables lorsqu'ils prennent des décisions cognitives sans l'aide de l'IA".

Pour la médecine, ce mélange soulève des questions inconfortables.

Qu'arrive-t-il à l'esprit d'un médecin lorsqu'il y a toujours un moteur de recommandation entre la pensée et l'action ?

À quelle vitesse les habitudes d'attention s'estompent-elles lorsque la machine fait la pré-lecture, le tri, même le premier coup de poignard à un diagnostic ?

S'agit-il simplement d'un revers temporaire pendant que nous nous habituons aux outils, ou est-ce le début d'un changement plus profond dans ce que font les médecins ?

Comme beaucoup de choses liées à l'IA, les réponses dépendent de la personne à qui vous demandez.

Une pièce avec plusieurs côtés

En apparence, tout type d'érosion cognitive chez les médecins en raison de l'utilisation de l'IA est alarmant. Cela suggère un certain désengagement avec les tâches à un niveau fondamental et même un biais d'automatisation - une dépendance excessive aux systèmes de machines sans même savoir que vous le faites.

Ou est-ce le cas ? Les données de l'étude "semblent aller à l'encontre de ce que nous voyons souvent", soutient Charlotte Blease, PhD, professeure agrégée à l'Université d'Uppsala, en Suède, et auteure du Dr. Bot : Pourquoi les médecins peuvent nous faire échouer - et comment l'IA pourrait sauver des vies. « La plupart des recherches montrent que les médecins sont algorithmiquement opposés. Ils ont tendance à tenir leur nez aux sorties d'IA et à les remplacer, même lorsque l'IA est plus précise. »

Si les cliniciens ne font pas défaut à la confiance aveugle, pourquoi les performances se sont-elles affaissées lorsque l'IA a été supprimée ?

Une possibilité est que les attitudes et les habitudes changent avec une exposition soutenue. « Nous pourrions commencer à voir un changement dans certains domaines, où les médecins commencent à se reporter à l'IA », dit-elle. « Et ce n'est peut-être pas une mauvaise chose. Si la technologie est toujours meilleure dans une tâche technique étroite, alors s'appuyer sur elle pourrait être souhaitable. »

La clé, à son avis, est le « point idéal judicieux de l'engagement critique ».

L'optique sociale peut couper dans l'autre sens.

Une récente expérience randomisée de la Johns Hopkins Carey Business School avec 276 cliniciens en exercice a révélé que les médecins qui s'appuyaient principalement sur l'IA générative pour prendre des décisions encouraient une "pénalité de compétence" aux yeux de leurs collègues. Ils étaient considérés comme moins capables que les pairs qui n'utilisaient pas l'IA, avec seulement un soulagement partiel lorsque l'IA a été présentée comme un deuxième avis.

Si vous acceptez l'IA, vous risquez le statut ; si vous la remplacez, vous risquez la précision. C'est un problème de conception et de gouvernance, et un problème d'attitude.

« L'érosion » dépend de la tâche.

Nigam Shah, MBBS, PhD, professeur de médecine à l'Université de Stanford, en Californie, et scientifique en chef des données pour Stanford Health Care, soutient que le point de départ est faux.

« La question à poser est de savoir dans quelle fidélité les outils d'IA peuvent-ils retirer complètement le travail de mon assiette », dit-il. « Par exemple, lorsque je m'entraînais, nous avions l'habitude de compter manuellement les globules blancs au microscope à l'aide d'un compteur de cellules. Aujourd'hui, nous utilisons un trieur de cellules. Nous ne demandons pas si la compétence d'un clinicien à faire le nombre différentiel de cellules manuellement a été atrophiée. »

En d'autres termes, toutes les tâches ne méritent pas la même préoccupation concernant l'érosion. Shah recommande d'éviter le diagnostic comme première frontière. « Il y a tellement de tâches simples à réparer qui sont négligées. » Pourquoi voulons-nous aller directement aux tâches les plus difficiles, comme la perspicacité du diagnostic et la planification du traitement, pour lesquelles nous passons 10 ans à former le médecin ? »

Ethan Goh, MD, directeur exécutif de Stanford ARISE (IA Research and Science Evaluation), convient que le recadrage de la liste des tâches modifie les enjeux. Mais il insiste également sur le fait que "différent" ne signifie pas nécessairement "diminué", ce qui "implique que les compétences cognitives d'un médecin se détérioreront", dit-il. La route vers "différent" commence par une cartographie explicite des tâches.

« Par exemple, une fois que nous avons commencé à cartographier les différentes façons dont les médecins utilisent l'IA - il s'agit d'une orientation d'étude en cours à Stanford et à Harvard pour laquelle ARISE a remporté une subvention Macy's AI in Education - nous pouvons commencer à mesurer la performance de l'IA seule par rapport à l'IA avec les médecins pour chacune de ces tâches », dit-il.

Ensuite, vous attribuez de l'attention avec un but. « Nous pouvons prendre une décision éclairée sur les tâches sur lesquelles appliquer les efforts cognitifs limités des médecins et sur quelles tâches nous devons nécessairement continuer à former et à tester les étudiants en médecine, les résidents et les médecins, afin que leurs compétences cognitives dans ces domaines ne se détériorent pas », poursuit Goh.

Il utilise l'aviation comme une analogie, soulignant que le pilote automatique a rendu le vol plus sûr, "mais les pilotes enregistrent toujours le temps manuel de "stick-and-dudder" dans les simulateurs, pratiquent les modes d'échec et subissent des contrôles de compétence réguliers", dit Goh.

Où les compétences commencent à glisser

Goh soutient que ce n'est pas que les compétences des médecins disparaissent simplement ; le vrai défi est de déterminer lesquels doivent être protégés. « Les robots et les procédures automatisées sont encore loin d'longtemps par rapport au travail de la connaissance », dit-il.

Il signale un risque cognitif à court terme. « Alors que l'IA devient si bonne, ou plus précise à 99 %, les experts humains se souviennent tellement à l'IA et deviennent sensibles aux biais d'automatisation et aux biais d'ancrage », dit-il. Ce n'est pas une raison d'arrêter ; c'est une raison de façonner comment et quand l'aide apparaît.

Si l'adoption dépasse la préparation, c'est un écart de leadership et d'éducation à combler, déclare Bertalan Meskó, PhD, directeur de l'Institut médico-futuriste, Budapest, Hongrie. « L'IA, et en particulier ceux qui développent l'IA, ne se soucient pas des compétences des médecins, mais se concentrent sur le remplacement des tâches basées sur les données et répétitives afin de réduire le fardeau des professionnels de la santé », dit-il. « Il serait de la responsabilité de ceux qui conçoivent des programmes médicaux de s'assurer que, tandis que les médecins apprennent à utiliser une gamme de technologies basées sur l'IA, leurs compétences et leur compréhension ne s'éroderont pas. »

Le résultat de la coloscopie souligne l'urgence, et il ne s'agit pas seulement d'un litige d'encadrement.

« L'utilisation de stéthoscopes a conduit à des niveaux de confiance et d'efficacité beaucoup plus élevés pour les professionnels de la santé dans le diagnostic des maladies cardiaques et pulmonaires », dit Meskó. « L'utilisation de l'IA devrait conduire à la même chose. Ce qui est déjà clair maintenant, c'est que la mise en œuvre élémentaire de l'IA dans les flux de travail médicaux ne soutiendra pas cette vision car cette technologie est beaucoup plus compliquée et moins intuitive qu'un stéthoscope. Cela nécessite un tout nouveau niveau de connaissances, de compétences et d'un état d'esprit pour que cela fonctionne en notre faveur. »

Si vous voulez une carte de l'endroit où les compétences vacillent en premier, Chiara Natali, doctorante à l'Université de Milan-Bicocca, en a une. Dans un récent examen, elle et ses collègues ont constaté que l'IA menace certaines des parties les plus centrales de la pratique clinique : la compétence pratique de l'examen des patients, la capacité à communiquer clairement et à gérer leurs préoccupations, l'art de construire un diagnostic différentiel et le jugement plus large qui lie tout cela.

Elle a également souligné deux vulnérabilités qui traversent toutes ces zones. L'un est particulièrement lié à l'IA : le risque que les cliniciens se méfient trop ou rejettent par réflexe les conseils algorithmiques. L'autre est plus collective : à mesure que les équipes s'appuient sur des machines, elles risquent de perdre la conscience partagée, ce qui rend plus difficile la détection des erreurs ou le soutien des autres lorsque les compétences commencent à s'estomper.

« L'IA n'étend pas seulement ce que les cliniciens peuvent voir (la couche sensorielle) ; elle façonne également ce qu'ils sont enclins à décider (la couche de décision) », dit Natali. Les outils qui « classent les différentiels, suggèrent les prochaines étapes ou pré-remplissent les rapports » peuvent pousser la déférence et « risquer d'éroder la méta-compétence de juger quand ne pas suivre une recommandation ».

Pouvons-nous récupérer les compétences perdues ? « Les principes de la neuroplasticité suggèrent « de l'utiliser ou de le perdre » », dit Natali. « Et inversement, utilisez-le délibérément pour le récupérer. »

L'hypothèse de Goh est que cela a moins à voir avec la formation et l'éducation et plus à voir avec la "conception réfléchie des interactions entre l'homme et l'ordinateur", dit-il. « Comment concevons-nous un produit d'IA ou un soutien à la décision clinique qui s'intègre dans le flux de travail existant du médecin ? Comment pouvons-nous introduire des signaux visuels et autres qui alertent un médecin si nécessaire ? »

Il souligne des modèles pratiques - files d'attente de triage pour la radiologie ; alertes de « filet de sécurité » de feux de circulation ; eConsults rédigées par l'IA qui maintiennent le fournisseur de soins primaires (PCP) en charge. « Cela signifie que le PCP a toujours le contrôle, tout en bénéficiant d'une éducation et d'une sensibilisation aux mesures qu'il pourrait prendre plus tôt au nom du patient. »

L'avenir : les inévitabilités, bonnes et mauvaises

L'horizon plus long revient à l'identité. Blease est direct sans excuses. « Je crois qu'au fil du temps, un certain degré de déqualification est inévitable, et ce n'est pas nécessairement une mauvaise chose », dit-elle. « Si l'IA s'améliore constamment dans certaines compétences techniques, insister pour que les médecins continuent à effectuer ces tâches juste pour préserver l'expertise pourrait en fait nuire aux patients. »

Elle met en garde contre un double standard qui "tient l'IA à un niveau beaucoup plus élevé que nous, les médecins humains". Et elle pose la question que la plupart des institutions esquivent. « Nous devons commencer à penser à un monde post-docte. Nous aurons besoin d'une variété de professionnels de la santé informés de l'IA. Une grande variété de nouveaux rôles émergeront, y compris dans la formation, les tests et la surveillance éthique de ces outils, dans la conservation des ensembles de données et dans le travail aux côtés de ces outils, pour fournir des soins et améliorer les résultats pour les patients. »

À plus court terme, elle veut "des conseils clairs et une formation courte et pratique pour les cliniciens", y compris "les dimensions éthiques de l'IA : parti pris, transparence, vie privée".

Alors, où cela laisse-t-il un interniste, un chirurgien ou un gastro-entérologue qui sera exhorté (et peut-être même contraint) à utiliser plus d'IA au cours des 5 prochaines années ?

Les experts ne sont pas toujours d'accone à œil, mais leurs conseils pointent dans une direction similaire. Choisissez d'abord les bons travaux pour la machine. Utilisez l'IA impitoyablement pour enlever la traînée administrative afin que peu d'attention humaine puisse être dépensée là où elle compte. Mesurer la dépendance et la performance ; séquencer l'assistance après l'effort initial ; protéger la pratique délibérée sans l'outil. Attendez-vous à ce que les compétences soient redistribuées et prévoyez-le dans les programmes d'études, les diplômes et la conception d'équipe. Concevoir des produits qui tiennent les cliniciens tichiens au bon moment et une explicabilité au premier plan. Apprenez aux cliniciens à dire aux patients quand ils ont fait confiance à la machine et quand ils ne l'ont pas fait.

Le meilleur résultat est que l'IA remodèle la médecine de manière intentionnelle : nous choisissons les tâches qu'elle devrait accomplir, nous mesurons quand elle aide ou nuit, et nous formons les cliniciens à rester profondément humains pendant que les machines effectuent un travail de modélisation évolutive. Dans cet avenir, le jugement clinique est moins déplacé que redéployé, les médecins passant moins d'heures à lutter contre les logiciels et plus de temps à donner un sens aux gens.

SYNTHÈSE

L'article examine la question de l'érosion des compétences cognitives chez les médecins due à l'utilisation de l'intelligence artificielle (IA), citant des études montrant une diminution des performances lorsque l'IA est retirée, notamment dans le domaine de la coloscopie. Des experts proposent différentes perspectives, certains considérant une certaine désaffection des compétences inévitable et potentiellement bénéfique si l'IA excelle dans certaines tâches techniques. D'autres soulignent que le problème réside dans le choix des tâches confiées à l'IA et la nécessité de protéger les compétences fondamentales telles que le jugement clinique et le diagnostic. Le texte insiste sur la nécessité d'une conception réfléchie des interactions homme-machine et d'une réforme des programmes de formation médicale pour maintenir les compétences et la conscience partagée au sein des équipes de soins. En fin de compte, l'objectif est de redéfinir le rôle du jugement clinique pour que les médecins puissent se concentrer sur les aspects humains des soins.

UN CONTRE-EXEMPLE

Tu, T., Schaekermann, M., Palepu, A. et al. Vers une intelligence artificielle diagnostique conversationnelle. Nature 642 , 442–450 (2025). https://doi.org/10.1038/s41586-025-08866-7

https://www.nature.com/articles/s41586-025-08866-7#citeas

Article libre d'accès

Au cœur de la médecine se trouve le dialogue médecin-patient, où une anamnèse habile permet un diagnostic et une prise en charge efficaces, ainsi qu'une confiance durable .

Les systèmes d'intelligence artificielle (IA) capables de dialoguer diagnostiquement pourraient améliorer l'accessibilité et la qualité des soins.

Cependant, se rapprocher de l'expertise des cliniciens constitue un défi majeur.

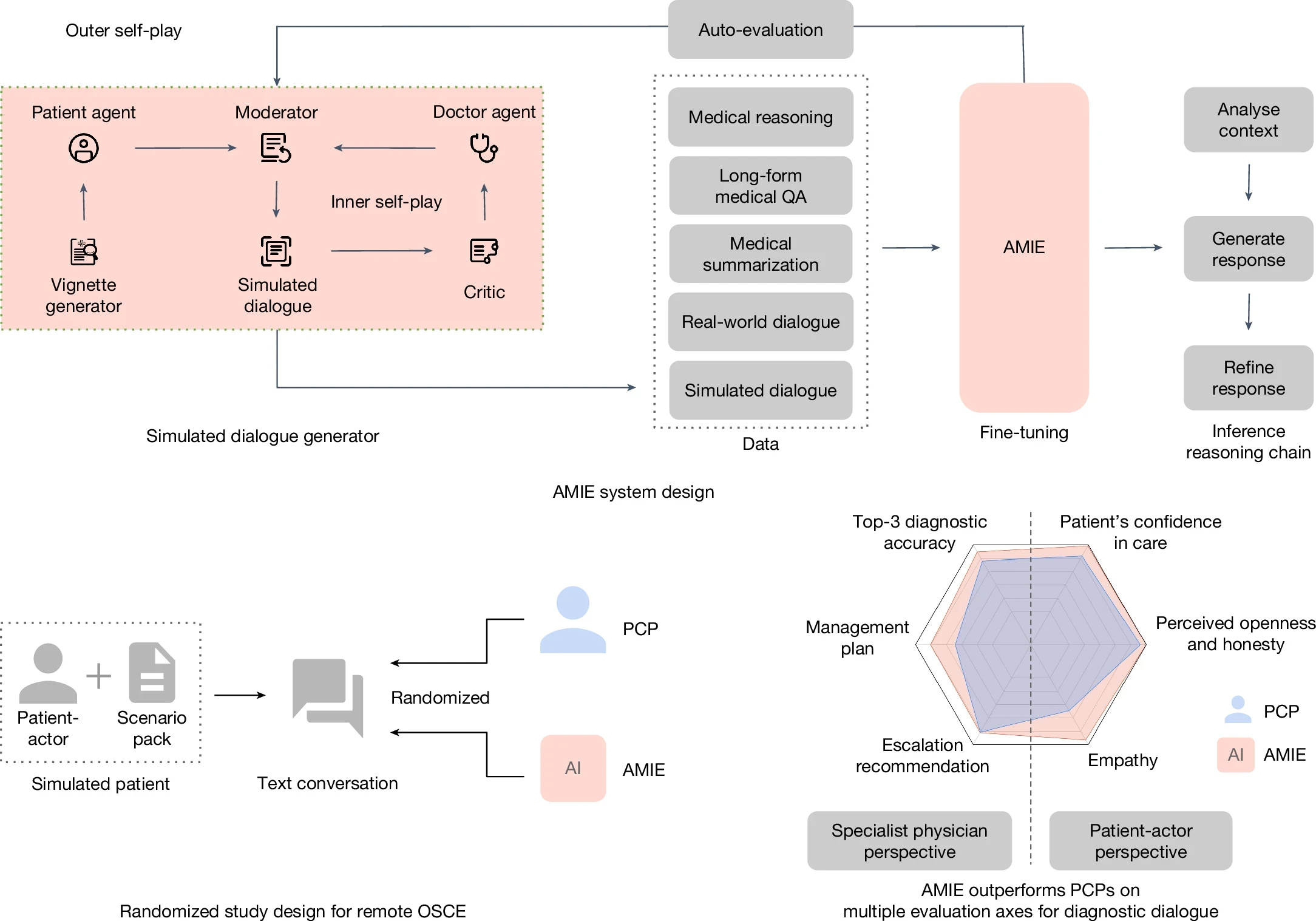

Nous présentons ici AMIE (Articulate Medical Intelligence Explorer), un système d'IA basé sur un modèle de langage étendu (LLM) optimisé pour le dialogue diagnostique.

AMIE utilise un environnement simulé basé sur le jeu en libre-service https://arxiv.org/abs/2305.10142 (2023)." data-track="click" data-track-action="reference anchor" data-track-label="link" data-test="citation-ref" aria-label="Référence avec un retour d'information automatisé pour adapter l'apprentissage à différentes pathologies, spécialités et contextes.

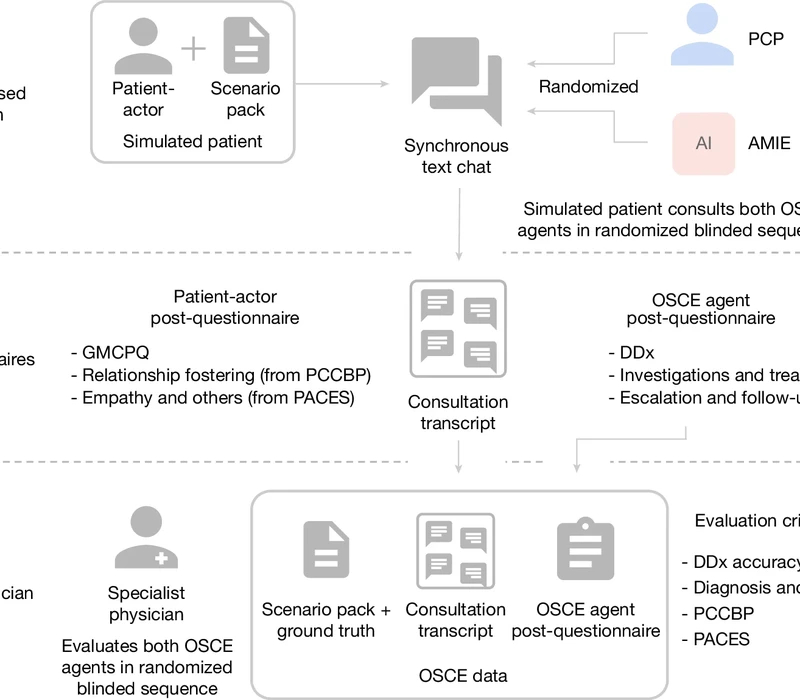

Nous avons conçu un cadre d'évaluation des axes de performance cliniquement significatifs, notamment l'anamnèse, la précision diagnostique, la prise en charge, les compétences en communication et l'empathie. Nous avons comparé les performances d'AMIE à celles des médecins généralistes dans une étude croisée randomisée en double aveugle portant sur des consultations textuelles avec des patients-acteurs validés, similaires à un examen clinique objectif structuré .

L'étude comprenait 159 cas cliniques de prestataires de soins au Canada, au Royaume-Uni et en Inde, 20 médecins de premier recours comparés à AMIE, ainsi que des évaluations de médecins spécialistes et de patients-acteurs. AMIE a démontré une plus grande précision diagnostique et une performance supérieure sur 30 axes sur 32 selon les médecins spécialistes et 25 axes sur 26 selon les patients-acteurs. Notre recherche comporte plusieurs limites et doit être interprétée avec prudence. Les cliniciens ont utilisé le clavardage textuel synchrone, qui permet des interactions à grande échelle entre les patients et les étudiants en médecine, mais cette méthode est peu courante en pratique clinique. Bien que des recherches supplémentaires soient nécessaires avant qu'AMIE puisse être transposé en situation réelle, les résultats représentent une étape importante vers l'IA diagnostique conversationnelle.

AMIE est une IA médicale conversationnelle optimisée pour le dialogue diagnostique. Son instruction est affinée grâce à une combinaison de dialogues médicaux réels et simulés, ainsi qu'à un ensemble diversifié de données de raisonnement médical, de questions-réponses (QA) et de synthèse. Nous avons notamment conçu un environnement de dialogue simulé basé sur l'auto-apprentissage, avec des mécanismes de rétroaction automatisés, afin d'adapter les capacités d'AMIE à différents contextes et spécialités médicales. Plus précisément, ce processus itératif d'auto-amélioration comprenait deux boucles d'auto-apprentissage : (1) une boucle d'auto-apprentissage « interne », où AMIE exploitait les commentaires critiques en contexte pour affiner son comportement lors de conversations simulées avec un agent patient IA ; et (2) une boucle d'auto-apprentissage « externe », où l'ensemble des dialogues simulés affinés était intégré aux itérations d'affinement ultérieures. Lors de l'inférence en ligne, AMIE a utilisé une stratégie de raisonnement en chaîne pour affiner progressivement sa réponse, conditionnée à la conversation en cours, afin de parvenir à une réponse précise et fondée au patient à chaque tour de dialogue. Nous avons conçu et mené un ECOS à distance en aveugle avec des patients-acteurs validés interagissant avec l'AMIE ou les médecins généralistes via une interface de chat textuel. Sur plusieurs axes, correspondant à la fois aux points de vue des médecins spécialistes (30 sur 32) et des patients-acteurs (25 sur 26), l'AMIE a été jugée supérieure à celle des médecins généralistes, sans être inférieure aux autres.

Un médecin généraliste et un médecin infirmier praticien (AMIE) réalisent (dans un ordre aléatoire) un ECOS virtuel à distance avec des patients simulés, par le biais d'une conversation textuelle synchrone en ligne à plusieurs tours, et répondent à un questionnaire post-intervention. Le médecin généraliste et l'AMIE sont ensuite évalués par les patients-acteurs et les médecins spécialistes.

Cet article sur le développement d'un système d'intelligence artificielle conversationnelle pour le diagnostic médical, appelé AMIE.

Système d'IA pour le diagnostic médical

* AMIE est un système d'intelligence artificielle établi sur un modèle de langage, optimisé pour le dialogue diagnostique.

* AMIE (Articulate Medical Intelligence Explorer) utilise un environnement simulé pour l'apprentissage à partir de dialogues médicaux.

* Il a été évalué par rapport à des médecins de soins primaires dans une étude randomisée.

* AMIE a montré une précision diagnostique supérieure, surpassant les médecins sur 30 des 32 axes d'évaluation.

Performance diagnostique d'AMIE

* AMIE a démontré une précision diagnostique plus élevée que celle des médecins de soins primaires.

* AMIE a obtenu des scores de précision top-k significativement plus élevés (P < 0,05).

* Les médecins n'ont pas toujours fourni une liste complète de diagnostics différentiels, avec une moyenne de 5,36 diagnostics.

* AMIE a surpassé les médecins dans tous les domaines sauf en obstétrique et gynécologie.

Efficacité dans l'acquisition d'informations

* AMIE a montré une efficacité comparable à celle des médecins dans l'acquisition d'informations.

* Les deux agents ont généré un nombre similaire de mots et de tours de conversation.

- *AMIE a été capable de formuler des diagnostics différentiels complets avec les mêmes informations que les médecins.

- * Les performances d'AMIE et des médecins étaient équivalentes en termes d'acquisition d'informations.

Qualité de la conversation

*AMIE a surpassé les médecins en termes de qualité de dialogue.

* Les acteurs patients ont évalué AMIE comme étant significativement meilleur sur 25 des 26 axes d'évaluation.

* Les médecins spécialistes ont également noté AMIE supérieur sur 30 des 32 axes d'évaluation.

* Les résultats ont montré que les consultations d'AMIE étaient perçues comme plus empathiques et communicatives.

Limitations et considérations

- * L'étude présente des limitations majeures concernant la méthode de consultation.

- * L'interface de chat textuel utilisée n'est pas représentative des pratiques cliniques habituelles.

- * Les médecins peuvent ne pas être habitués à ce format de communication, ce qui pourrait affecter leurs performances.

- * Des recherches supplémentaires sont nécessaires pour traduire les résultats d'AMIE dans des contextes cliniques réels.

Formation et évaluation des cliniciens

- Cette section aborde le processus de formation des cliniciens et l'évaluation de leurs performances dans des consultations simulées.

* Les cliniciens ont participé à des sessions pilotes avec une interface textuelle avant l'évaluation.

* Les conversations étaient limitées dans le temps, ce qui peut ne pas refléter les consultations réelles. - * Les réponses d'AMIE étaient plus longues et mieux structurées que celles des cliniciens, ce qui pourrait influencer la satisfaction des patients.

- * Des recherches futures pourraient explorer l'impact de la courbe d'apprentissage et la familiarité avec la télémédecine.

Dialogue simulé et amélioration par auto-jouabilité

- Cette section décrit l'utilisation de données simulées pour améliorer les capacités d'AMIE dans des dialogues médicaux.

- * Les données simulées ont permis de couvrir une large gamme de conditions médicales.

- AMIE a eu des difficultés avec certains patients, notamment ceux ayant une faible littératie en anglais.

- * Un processus d'auto-jouabilité a été utilisé pour affiner les dialogues, mais les améliorations étaient limitées par la capacité à fournir des retours efficaces.

- * Les dialogues simulés avaient moins de tours de conversation que les dialogues réels, en raison des différences de style de communication.

Évaluation de la Qualité et des Biais

Cette partie traite des défis liés à l'évaluation de la qualité des dialogues médicaux et des biais potentiels.

- * Le protocole d'évaluation a des limites concernant la détection des biais et des problèmes d'équité.

- * Des études antérieures ont montré que la communication des médecins varie selon la race et le niveau de littératie des patients.

- * Une approche participative est nécessaire pour développer des cadres d'évaluation de l'équité et des biais.

- * Des recherches supplémentaires sont nécessaires pour évaluer les modèles de dialogue médical pour l'équité et la robustesse dans des contextes multilingues.

Déploiement et utilisation éthique

Cette partie aborde les considérations éthiques et pratiques pour le déploiement d'AMIE dans les soins de santé.

- * La transition d'un prototype de recherche à un outil sûr nécessite des recherches supplémentaires sur la sécurité et la fiabilité.

- * Des méthodes d'estimation de l'incertitude doivent être développées pour permettre le renvoi à des experts humains.

- * Il est crucial de surveiller les biais et les vulnérabilités de sécurité lors du déploiement.

- * Les systèmes d'IA doivent évoluer avec les connaissances cliniques pour rester pertinents.

Conclusion sur le Potentiel des Systèmes d'IA Médicale

Cette partie résume le potentiel des systèmes d'IA pour améliorer les interactions médicales.

- * AMIE démontre des capacités prometteuses pour les dialogues diagnostiques et la prise d'historique clinique.

- * Les résultats doivent être interprétés avec prudence, car des recherches supplémentaires sont nécessaires pour assurer la sécurité et l'efficacité.

- * Si réussis, des systèmes comme AMIE pourraient transformer les systèmes de santé en offrant des soins de qualité à tous.

Interfaces utilisées pour la consultation en Ligne

* Les consultations en ligne entre les acteurs patients et les médecins ont été réalisées via une interface de chat textuel synchronisé.

- * Les consultations ont impliqué des acteurs patients interagissant avec AMIE ou des médecins de soins primaires (PCPs).

- * Le processus d'évaluation a été facilité par une interface de notation pour les médecins spécialistes.

- * Les médecins spécialistes ont reçu des informations sur les scénarios, y compris un guide de diagnostic différentiel et des transcriptions de consultation.

Précision du diagnostic différentiel (DDx)

L'exactitude du DDx a été évaluée pour des scénarios positifs et négatifs.

- * Pour 149 scénarios positifs, des tests bootstrap à deux côtés ont montré des différences significatives (P < 0,05) pour tous les k.

- * Les valeurs P ajustées pour les états de maladie positive par rapport à la vérité de terrain étaient significatives, avec des valeurs allant de 0.0001 à 0.0041.

- * Pour 10 scénarios négatifs, les différences n'étaient pas significatives en raison de la petite taille de l'échantillon.

Précision du DDx par Spécialité

L'exactitude du DDx a été évaluée selon la spécialité des scénarios.

- * Les résultats étaient significatifs pour la médecine interne (N = 16) et la médecine respiratoire (N = 32) pour tous les k.

- * Les spécialités comme la cardiologie (N = 31) et la gastro-entérologie (N = 33) n'ont pas montré de résultats significatifs.

- * Les valeurs P ajustées pour la neurologie étaient significatives pour k > 5.

Précision du DDx par localisation

La performance de DDx a été comparée entre le Canada et l'Inde.

- * Pour 77 cas au Canada, les différences entre AMIE et les PCPs étaient significatives pour tous les k.

- * Pour 82 cas en Inde, les différences étaient également significatives.

- * Les scénarios partagés entre le Canada et l'Inde n'ont pas montré de différences significatives dans les performances.

Auto-évaluation de la performance du DDx

L'auto-évaluation a été réalisée pour comparer les performances d'AMIE et des PCPs.

- * Les résultats ont montré que la performance d'AMIE était significative par rapport à la vérité de terrain pour k > 3.

- * Les comparaisons entre AMIE et les PCPs n'ont pas montré de significativité pour les transcriptions de consultation.

Verbosité de la consultation et efficacité

L'efficacité de l'acquisition d'informations a été mesurée par le nombre de mots échangés.

- * Le nombre total de mots échangés par AMIE et les PCPs a été comparé.

- * Le nombre de tours de conversation entre AMIE et les PCPs a également été évalué.

- Les différences dans l'exactitude du diagnostic différentiel (DDx) n'étaient pas significatives lors de l'évaluation des premiers tours de conversation de chaque consultation.

Détails des rubriques d'Évaluation

Des rubriques spécifiques ont été utilisées pour évaluer les compétences cliniques.

- * La rubrique PACES a évalué des compétences en communication clinique et en jugement clinique.

- * La rubrique PCCBP a évalué la communication centrée sur le patient.

- * La rubrique de diagnostic et de gestion a évalué l'appropriation des diagnostics et des recommandations de gestion.

SYNTHÈSE

Cette publication scientifique décrit l'introduction d'AMIE (Articulate Medical Intelligence Explorer), un système d'intelligence artificielle basé sur un Grand Modèle de Langage (LLM), optimisé pour le dialogue diagnostique clinique. L'étude présente une évaluation comparative de ce système avec des médecins de soins primaires (PCPs) lors de consultations textuelles randomisées et en double aveugle avec des patients-acteurs validés. Les résultats indiquent qu'AMIE a démontré une précision diagnostique supérieure et une performance de communication et d'empathie jugée meilleure par les spécialistes et les patients-acteurs sur la majorité des axes d'évaluation. Les auteurs soulignent néanmoins les limites de l'étude, notamment l'utilisation d'une interface de chat textuel et la nécessité de recherches supplémentaires avant une intégration dans des contextes cliniques réels.

Commentaire

Le médecin et l'IA doivent fusionner et ne former qu'un. Le médecin utilisera l'outil IA mais le médecin restera le décideur : diagnostic et thérapeutique. Cependant, médecin et IA doivent s'habituer à être un couple efficace et efficient. Tout cela se fera lentement mais surement en multipliant l'efficacité par l'IA du médecin. Il ne faut en aucun cas que le médecin cède à la facilité diagnostique par l' IA. Erreur redoutable qu'il faut éviter à tout prix.

Copyright : Dr Jean-Pierre Laroche/2025