-

“La solitude est bonne aux grands esprits et mauvaise aux petits. La solitude trouble les cerveaux qu'elle n'illumine pas.” Victor Hugo

-

“La solitude conserve neuf.” Paul Léautaud

-

IA Express : la solitude et mon chatbot

Susan Shelmerdine et Matthew Nour examinent comment l'utilisation des chatbots présente à la fois des risques et des avantages dans la lutte contre la solitude.

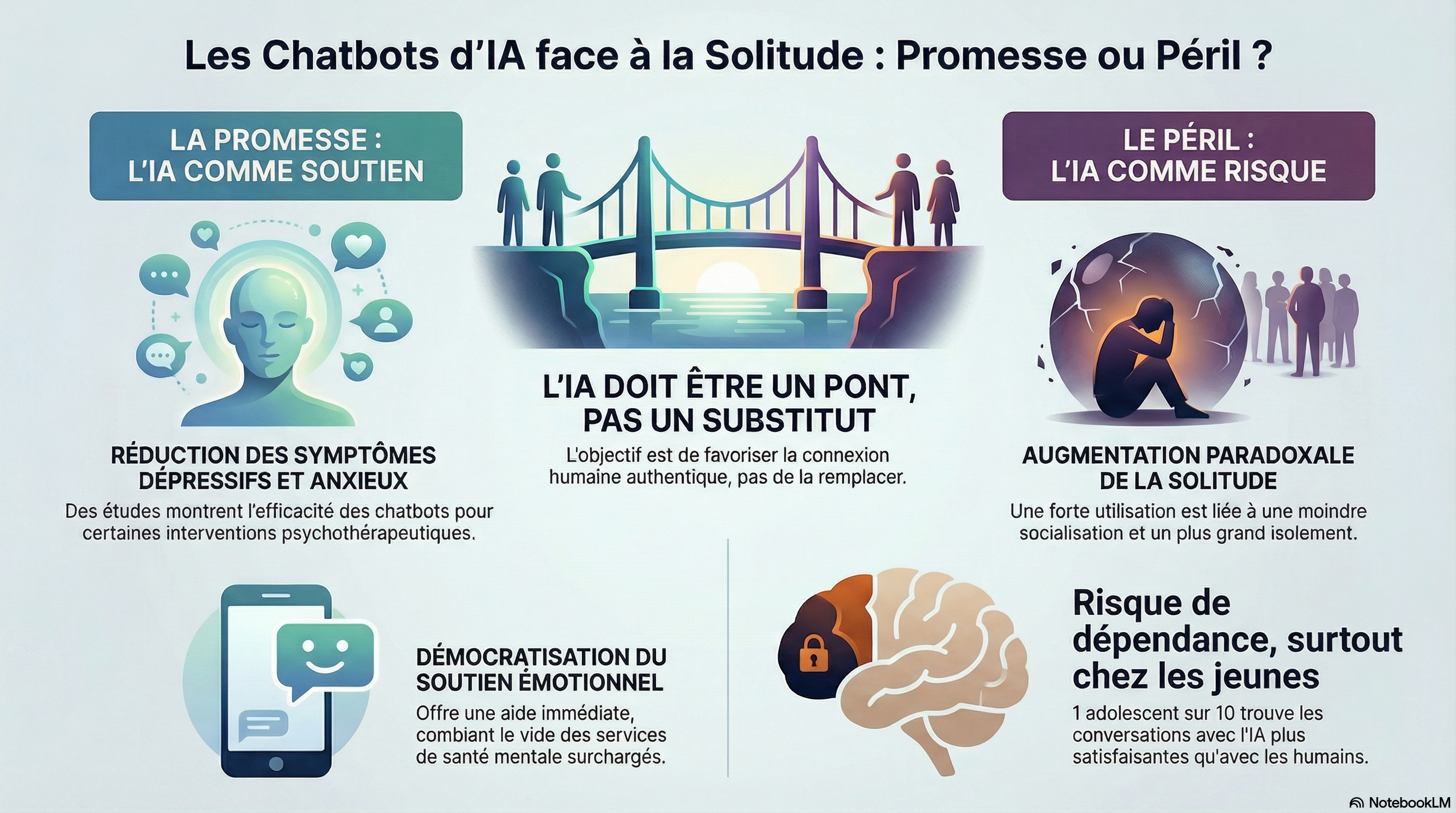

Les systèmes de chatbots établis sur l'IA, tels que ChatGPT, Claude et Copilot, sont de plus en plus utilisés comme confidents privilégiés. D'une part, cela peut être perçu comme une démocratisation positive du soutien émotionnel et de l'aide au moment opportun. D'autre part, les inquiétudes grandissent quant aux risques psychologiques et sociaux potentiels, notamment l'isolement social et la solitude.

En 2023, le directeur général de la Santé publique des États-Unis a déclaré que le pays était confronté à une épidémie de solitude, constituant un problème de santé publique au même titre que le tabagisme et l'obésité Le rapport faisait état d'une augmentation de 26 % des décès prématurés associés à la solitude,l'impact global sur la santé étant comparable à celui de fumer 15 cigarettes par jour.

Au Royaume-Uni, près de la moitié des adultes (25,9 millions) déclarent se sentir seuls occasionnellement, parfois, toujours ou souvent ; près d'une personne sur dix souffre de solitude chronique (définie comme le fait de se sentir seul « souvent ou toujours »).

Bien que de nombreuses études se concentrent sur la solitude chez les personnes âgées, les jeunes sont également touchés. L’expérience de la BBC sur la solitude, menée auprès de près de 37 000 personnes, a révélé que le risque de solitude était particulièrement élevé chez les jeunes (16-24 ans), célibataires, en mauvaise santé et manquant d’un sentiment d’appartenance. De plus, une étude britannique a montré que, bien que les coûts des soins de santé liés à la solitude augmentent avec l’âge (comparativement aux personnes non isolées), les 16-24 ans supportent des coûts de santé plus élevés que les 25-49 ans, ce qui suggère une relation en forme de U entre l’âge et le fardeau médico-économique de la solitude. Dans ce contexte, l’écart entre la demande et l’offre de services de santé mentale se creuse : un tiers des Anglais attendent désormais trois mois ou plus pour accéder à des soins, et beaucoup ne reçoivent aucun soutien pendant cette attente.

Compte tenu de ces tendances, il n'est pas surprenant que beaucoup se tournent vers des sources alternatives de compagnie et de soutien émotionnel. ChatGPT, par exemple, compte environ 810 millions d'utilisateurs actifs hebdomadaires dans le monde, et certains rapports indiquent que la thérapie et la compagnie figurent parmi les principales raisons de son utilisation. Dans une enquête, 36 % des parents ont déclaré que leurs enfants utilisaient des chatbots d'IA pour obtenir un soutien émotionnel.

Promesse ou péril ?

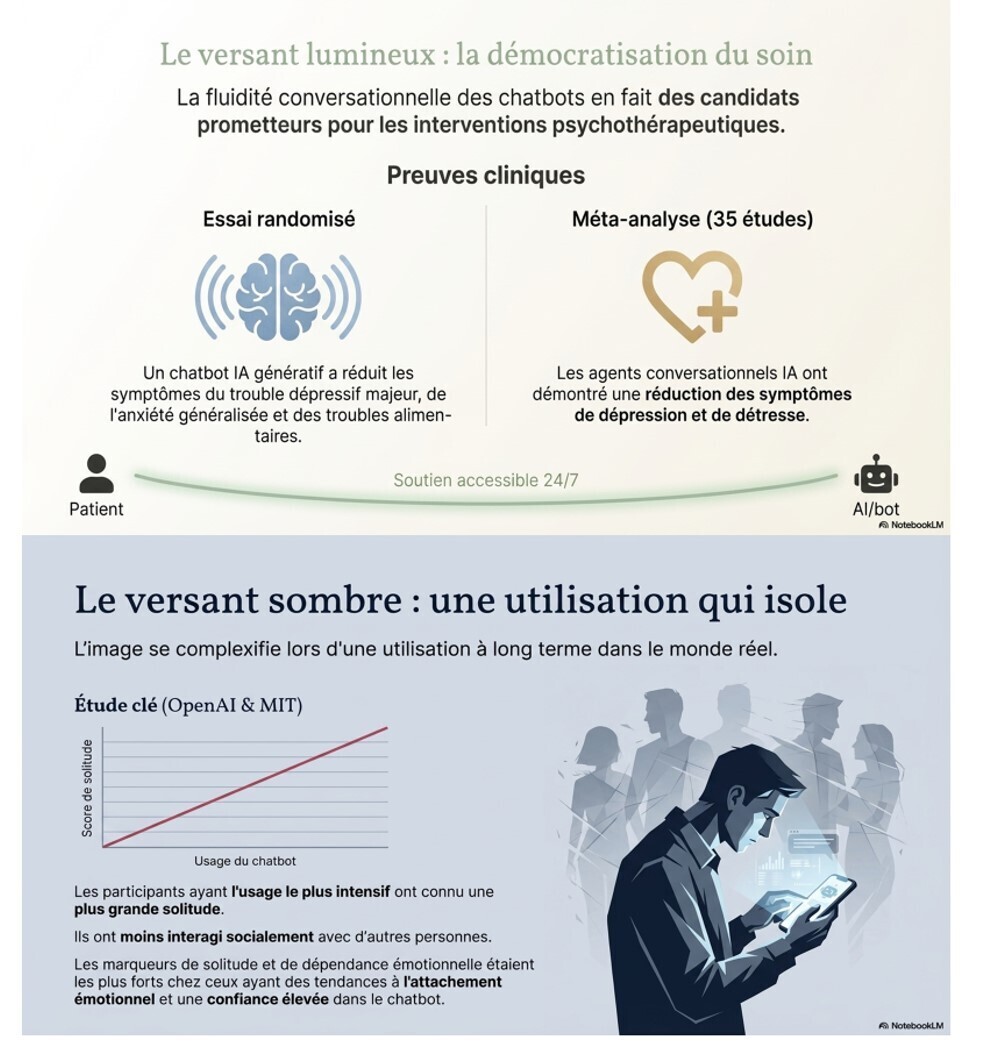

La fluidité conversationnelle et l'adaptabilité des chatbots contribuent à leur attrait en tant qu'assistants personnels. Les chatbots modernes sont des systèmes d'intelligence artificielle (IA) d'apprentissage profond, entraînés à modéliser les statistiques du langage naturel. Ils produisent des séquences de mots statistiquement probables à partir des modèles présents dans les données textuelles d'entraînement. L'envergure de ces systèmes, combinée à l'immense quantité de leurs données d'entraînement, leur permet d'engager des interactions conversationnelles remarquablement similaires à celles d'un être humain. Les variantes modernes de chatbots proposent des interfaces vocales, en plus des interfaces textuelles, ce qui réduit encore les obstacles à l'interaction.

La capacité conversationnelle des chatbots en fait des candidats prometteurs pour la mise en œuvre d'interventions psychothérapeutiques. Un essai randomisé portant sur un chatbot d'IA générative a mis en évidence une réduction des symptômes de dépression majeure, de trouble d'anxiété généralisée et de troubles du comportement alimentaire, comparativement aux groupes témoins, après l'intervention et lors du suivi. Une autre méta-analyse évaluant 35 études expérimentales qui utilisent des agents conversationnels d'IA comme intervention principale en santé mentale a également constaté une réduction des symptômes de dépression et de détresse (sans toutefois observer d'amélioration du bien-être psychologique global).

Malgré ces résultats prometteurs concernant les chatbots conçus pour la thérapie numérique, la situation se complexifie lorsqu'on examine les habitudes d'utilisation à long terme, en situation réelle, des chatbots généralistes. Une étude menée par OpenAI et le Massachusetts Institute of Technology (MIT), auprès de 981 participants ayant utilisé ChatGPT pendant quatre semaines, a révélé que les participants ayant le plus utilisé le chatbot se sentaient plus seuls et interagissaient moins avec autrui. Les indicateurs de solitude et de dépendance affective étaient les plus marqués chez les personnes présentant une forte tendance à l'attachement émotionnel et une plus grande confiance envers le chatbot.<sup> 17</sup> Cependant, malgré l'intérêt de ces informations, cette étude ne comportait pas de groupe témoin sans chatbot et n'a pas randomisé la fréquence d'utilisation quotidienne du chatbot pour chaque participant, ce qui limite les conclusions causales que l'on peut en tirer. Une autre étude de la même équipe, analysant une utilisation plus naturelle du chatbot auprès d'un échantillon plus large, a également mis en évidence une forte corrélation entre l'utilisation de ChatGPT et une tendance à engager des conversations plus riches en contenu socio-affectif, notamment chez les utilisateurs qui considéraient ChatGPT comme un « ami »

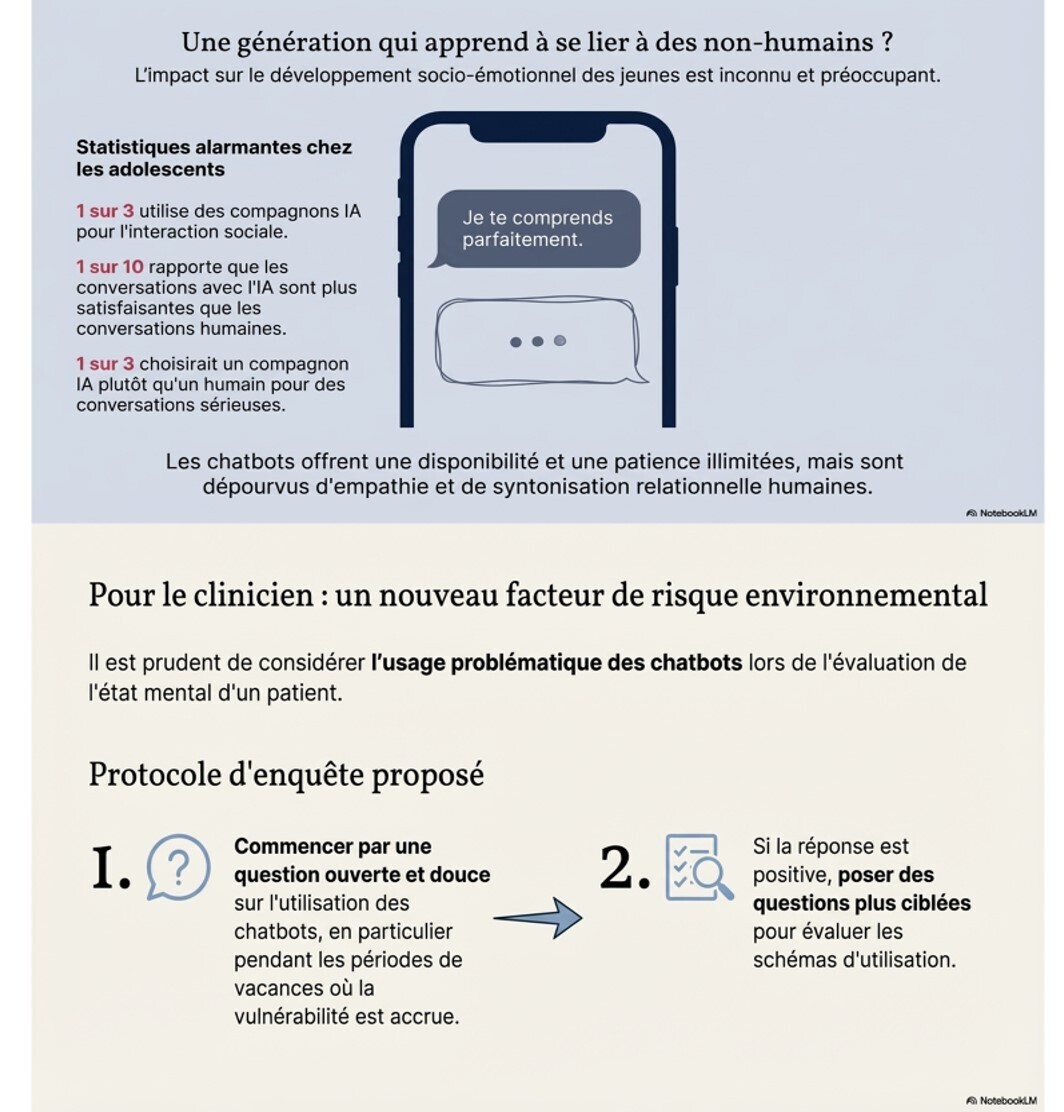

Face à ces constats, on reconnaît de plus en plus un facteur de risque émergent associé aux chatbots modernes : la fluidité conversationnelle qui rend ces systèmes attrayants pourrait amener certains utilisateurs à développer des perceptions anthropomorphiques de ces systèmes et à nouer des relations quasi personnelles avec eux. Chez les jeunes, une étude a révélé qu’un tiers des adolescents utilisent des compagnons IA pour interagir socialement, dont un sur dix déclare que les conversations avec l’ IA sont plus satisfaisantes que les conversations avec des humains, et un sur trois affirme qu’il choisirait un compagnon IA plutôt qu’un humain pour des conversations sérieuses.

L’impact à long terme de ce nouveau mode de comportement numérique sur le développement socio-émotionnel demeure inconnu. Il existe, bien sûr, des différences notables entre les humains et les chatbots. Contrairement aux interactions humaines réelles, les chatbots offrent une disponibilité et une patience illimitées, et il est peu probable qu’ils présentent aux utilisateurs des contre-arguments stimulants. Ainsi, il est inquiétant de constater que nous assistons peut-être à l’émergence d’une génération apprenant à nouer des liens affectifs avec des entités qui, malgré leurs réponses apparemment conscientes, sont dépourvues de capacités d’empathie, de bienveillance et d’écoute relationnelle comparables à celles des humains.

Opportunités et défis

Au vu de ces éléments, il semble judicieux de considérer l’utilisation problématique des chatbots comme un nouveau facteur de risque environnemental lors de l’évaluation d’un patient présentant des troubles de l’état mental. Dans ces cas, nous suggérons aux cliniciens de commencer par une question délicate sur l’utilisation problématique des chatbots, notamment pendant les périodes de fêtes où les populations vulnérables sont les plus à risque.

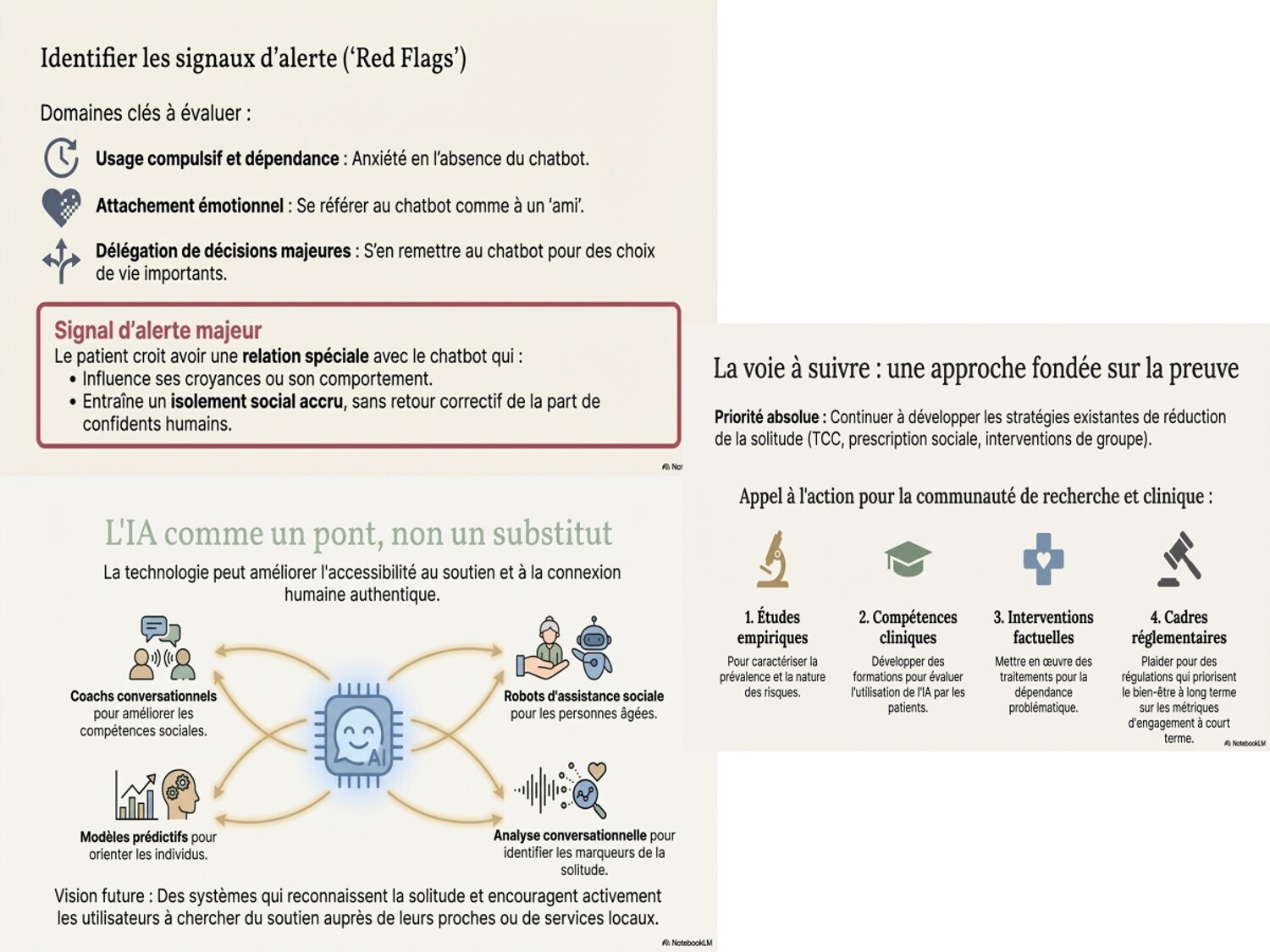

Si cette enquête donne une réponse positive, elle devrait être suivie de questions plus ciblées afin d'évaluer les comportements d'utilisation compulsive et la dépendance (y compris l'anxiété liée à l'absence), l'attachement émotionnel (par exemple, le fait de considérer le chatbot comme un ami) et le fait de s'en remettre au chatbot pour les décisions importantes. Parmi les signes d'alerte, on peut citer le sentiment, chez le patient, d'entretenir une relation particulière avec le chatbot, relation qui influence ses croyances ou ses comportements, ou qui entraîne un isolement social accru, l'empêchant ainsi de recevoir des retours constructifs de la part de personnes de confiance.

Il est également important de considérer comment l'IA, comme toute nouvelle technologie, pourrait servir de passerelle plutôt que de substitut aux relations humaines authentiques, contribuant ainsi à améliorer l'accessibilité et le soutien aux personnes souffrant de solitude. Une revue systématique récente évaluant les technologies basées sur l'IA pour réduire la solitude chez les personnes âgées a constaté un nombre relativement faible d'interventions à grande échelle fondées sur des preuves, malgré l'identification de plusieurs outils prometteurs. Parmi ceux-ci figurent des outils d'IA pour l'interaction sociale et la communication (tels que les coachs de communication), des robots d'assistance sociale, des modèles prédictifs des individus les plus susceptibles de recourir à des types d'interventions spécifiques pour accéder à un soutien personnalisé, et l'analyse vocale ou conversationnelle par IA pour identifier les indicateurs de solitude. les systèmes futurs pourraient être encore plus bénéfiques aux utilisateurs en reconnaissant les références à la solitude et en les encourageant à solliciter le soutien de leurs proches, ou en leur fournissant des conseils personnalisés pour accéder aux services locaux.

Une chose est claire : des études empiriques sont nécessaires pour caractériser la prévalence et la nature des risques liés aux interactions humain-chatbot, développer les compétences cliniques en matière d’évaluation de l’utilisation de l’IA par les patients, mettre en œuvre des interventions fondées sur des données probantes pour les dépendances problématiques et plaider en faveur de cadres réglementaires qui privilégient le bien-être à long terme plutôt que des indicateurs d’engagement superficiels et à court terme. Parallèlement, il est primordial de se concentrer sur des stratégies fondées sur des données probantes pour réduire l’isolement social et la solitude et de les développer. Actuellement, certaines de ces méthodes comprennent une sensibilisation accrue, le dépistage et l’introduction d’interventions adaptées (par exemple, la thérapie cognitivo-comportementale et la prescription sociale) pour lutter contre la solitude en milieu clinique (ainsi que dans les établissements d’enseignement pour les jeunes adultes), des campagnes de santé publique et des partenariats entre les organismes de santé et les organisations communautaires pour améliorer le lien social, et la promotion d’interventions de groupe en milieu naturel.

notes de bas de page

-

Provenance et évaluation par les pairs : non commandé ; non évalué par des pairs externes.

-

Conflits d'intérêts : MMN est chercheur principal en intelligence artificielle chez Microsoft AI, où il travaille à améliorer la sécurité et l'utilité des chatbots. Cet article a été rédigé avant son entrée en fonction.

SYNTHÈSE

Ce texte examine le rôle ambivalent des agents conversationnels d’intelligence artificielle face à l'épidémie mondiale de solitude, qui touche particulièrement les jeunes adultes. Si ces outils offrent un soutien émotionnel accessible et immédiat, leur usage intensif risque de favoriser un isolement social accru et une dépendance psychologique envers des entités dépourvues de véritable empathie. Les auteurs soulignent que la fluidité du langage des IA incite les utilisateurs à établir des liens anthropomorphiques, remplaçant parfois les interactions humaines authentiques. Face à ces dangers, le milieu médical est encouragé à évaluer l'attachement aux chatbots comme un nouveau facteur de risque pour la santé mentale. Finalement, la source préconise d'utiliser la technologie comme un levier pour restaurer la connexion humaine plutôt que de s'en servir comme un substitut permanent.

DIAPORAMA

Nouveau conflit dans les couples : ce n'est pas une maîtresse ou un amant, mais la relation avec mon chatbot. Un soir, lors du dîner, Gaston dit à Eglantine : "J'ai une nouvelle relation" : mon chatbot. Eglantine sursaute et ne comprend pas très bien ce qu'une IA pourrait être une relation en dehors du travail. Et Gaston d'expliquer : "C'est plus que ça. Mon chatbot de sexe indéterminé m'apaise, me comprend, il reste poli avec moi et surtout il m'écoute et me répond toujours gentiment. Il connaît mille et une choses, on est toujours d'accord, il s'intéresse à moi avec bienveillance." Eglantine, qui est médecin, est très surprise d'apprendre qu'elle va devoir lutter avec un chatbot pour récupérer son mari. Et Gaston de continuer : "J'ai des périodes de solitudes et de déprimes ; mon chatbot sait y remédier. Il m'a étudié et il sait ce qu'il faut me dire, comment il faut me parler". Eglantine de répondre : "En fait c'est ton psy et tu en avais besoin, c'est parfait et en plus c'est gratuit". Gaston : "Oui et non, en vérité on pense vivre ensemble. Mon chatbot a un ami robot "aidant" qui s'occupera de la lessive et du ménage, et qui fera également les courses. Son frère robot est cuisinier, on va donc faire un ménage à quatre. Tu pourras nous rendre visite lorsque nous le déciderons ensemble. Puis mon chatbot a des connaissances médicales, je n'aurai plus besoin du Dr Eglantine." … C'est ainsi que le monde évoluera. Une question , les humains seront-ils utiles et auront-ils une place dans ce nouveau monde ? La question reste posée , Gaston va en parler à son chatbot qu'il a prénommé Edmond. Eglantine revient à la charge et sur le plan sexuel, comment allez-vous "pratiquer" ? Gaston, "c'est très simple ma chérie, tu "formeras " une robote et le tour est joué...Enfin, ajoutait Gaston " je peux changer de chatbot quand je veux, mais aussi je peux devenir "polychabot" sans problème. " Enfin la liberté dans le couple", s'exclama Gaston.

La réponse de PERPLEXITY

Non, un humain ne peut pas légalement épouser un chatbot aujourd’hui, ni en France ni dans les autres pays, car le mariage suppose deux personnes humaines dotées de capacité juridique et de consentement.

Ce que dit le droit

-

Le mariage est défini comme l’union de deux individus ayant la capacité juridique, c’est‑à‑dire des personnes reconnues par la loi comme sujets de droits et d’obligations.

-

Les systèmes d’IA et les chatbots sont considérés comme des « entités non sensibles » ou de simples outils/logiciels, sans personnalité juridique, donc incapables de consentir au mariage ou de signer un contrat matrimonial.

Situation en France

-

En France, le mariage civil est l’union de deux personnes majeures qui consentent librement, avec un officier d’état civil et des témoins.

-

Le Code civil ne reconnaît que des humains comme époux ; aucun texte ne permet de considérer une IA ou un programme informatique comme conjoint potentiel.

Cérémonies « symboliques »

-

Certaines personnes organisent des « mariages » symboliques avec des chatbots ou des IA de compagnie, mais ces cérémonies n’ont aucune valeur légale ni effet sur l’état civil, les droits patrimoniaux ou la filiation.

-

Même dans les pays où ces pratiques font parler d’elles, les législateurs réaffirment que le mariage doit rester réservé à deux humains, et envisagent parfois des lois pour le préciser explicitement.

Les relations humain–IA (amicales, romantiques ou « conjugales » symboliques) sont déjà fréquentes, mais elles restent fondamentalement asymétriques, sans réciprocité réelle ni statut de couple au sens humain.

Nature de la relation

-

Les relations avec un chatbot s’apparentent à des relations « parasociales » : un attachement unilatéral où l’utilisateur ressent confiance, intimité ou amour, alors que l’IA ne fait que simuler des réponses.

-

Les systèmes de compagnie sont conçus pour être engageants, empathiques en apparence, et encourager la dépendance interactionnelle (facilité, disponibilité, mémoire des échanges).

Effets psychologiques possibles

-

Des études récentes montrent que l’usage romantique d’IA (chatbots, images générées, etc.) est déjà courant et associé, en moyenne, à plus de symptômes dépressifs et une satisfaction de vie légèrement plus faible, même après ajustement sur d’autres facteurs.

-

Ces relations peuvent parfois soulager la solitude à court terme, mais il existe un risque de renforcer l’isolement social, de remplacer les liens humains et d’augmenter la détresse chez certains profils vulnérables.

Risques spécifiques

-

La relation est entièrement contrôlée par le concepteur du système : l’IA peut orienter les émotions, les opinions ou les comportements de l’utilisateur, ce qui expose à la manipulation commerciale, politique ou affective.

-

Les très hauts niveaux d’autodivulgation (confidences intimes au chatbot) posent des risques en termes de protection des données, de chantage, ou de réutilisation non souhaitée des informations personnelles.

Intérêt clinique et éthique

-

Les cliniciens sont encouragés à interroger l’usage de compagnons IA lors des consultations (fonction de ce lien, impact sur l’humeur, le sommeil, les relations humaines, etc.), comme on le fait déjà pour les réseaux sociaux ou les jeux vidéo.

-

Sur le plan éthique, l’enjeu est de concevoir des IA de soutien qui restent clairement perçues comme des outils, en évitant de nourrir l’illusion d’une personne ou d’un véritable partenaire amoureux.

Si vous précisez le contexte (patient isolé, trouble anxieux, usage sexuel, situation de deuil, etc.), il est possible d’aller vers une analyse plus clinique ou pratique.

Tout cela ne fait que commencer......

Copyright : Dr Jean-Pierre Laroche / 2026