Les agents d’IA sont capables d’effectuer différentes tâches de façon plus ou moins autonome.

À mesure qu’ils sont intégrés à nos outils et à nos échanges personnels et professionnels, c’est toute la société qui doit décider ce qu’elle souhaite déléguer… et ce qu’elle préfère préserver.

En arrivant au bureau, un mail vous attend. Votre client voulait une mise à jour sur sa commande. Mais, un agent IA a déjà consulté les données de livraison et envoyé un message de suivi. Vous n’avez rien eu à faire.

Ce n’est pas de la science-fiction. Les agents IA sont sur le point de transformer en profondeur nos façons de travailler. L’entreprise américaine de conseil Gartner estime que 15 % des décisions professionnelles quotidiennes seront prises par des agents IA d’ici 2028, et 33 % des entreprises les utiliseront (contre 1 % en 2024). Ces agents ne sont pas de simples assistants mais des entités capables d’agir, de décider et parfois de collaborer entre elles. Leur émergence pose des questions fondamentales sur le rôle des humains au travail.

À quand les sessions de team building (« renforcement d’équipe ») avec des IA ? Cette image provient de Studiostoks, Shutterstock.

Que sont les agents IA ?

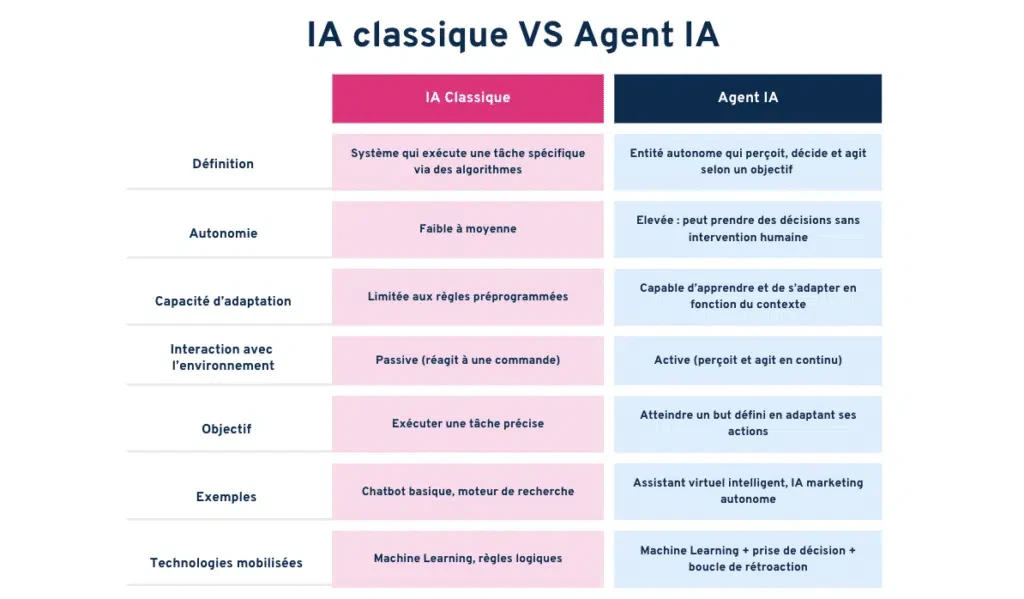

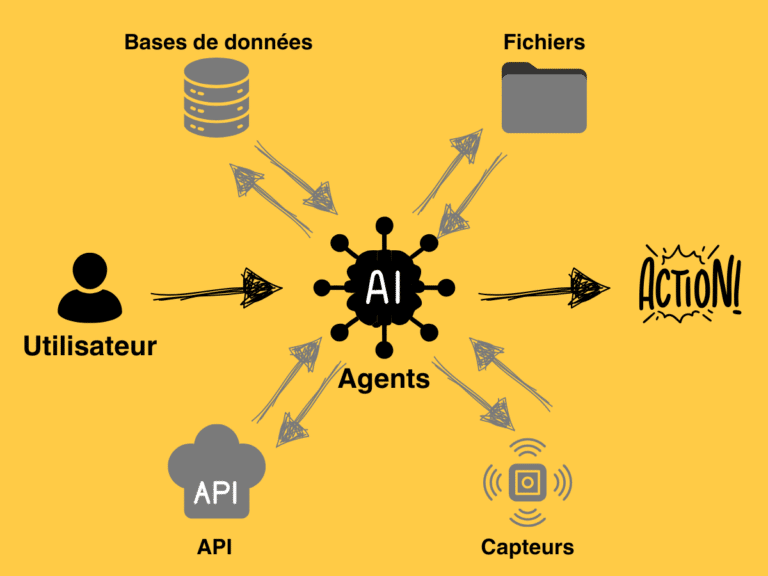

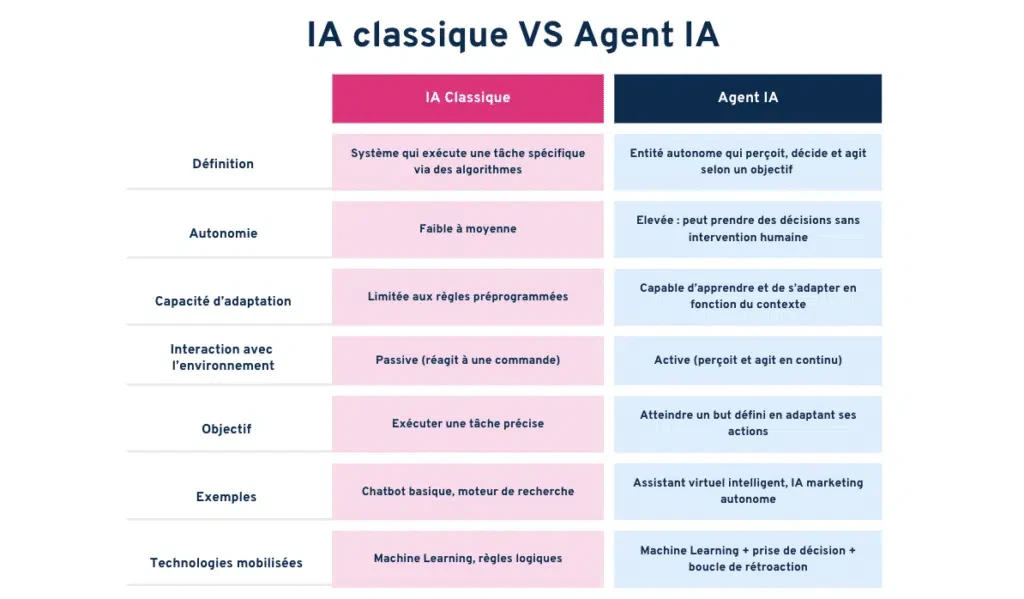

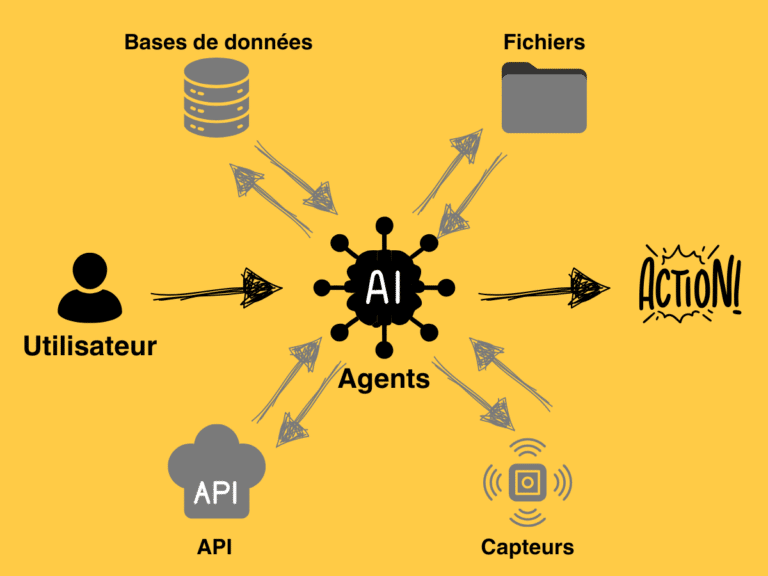

Un agent IA est un logiciel (semi)autonome qui utilise des techniques d’intelligence artificielle pour percevoir, prendre des décisions, accomplir des tâches et atteindre des objectifs prédéterminés, dans des environnements physiques ou numériques.

Un agent IA peut agir pour le compte d’un utilisateur ou d’un autre système, par exemple un autre agent logiciel, en concevant son processus de travail et utilisant les outils disponibles.

Certains agents suivent une logique strictement scriptée, tandis que d’autres sont dotés d’une plus vaste autonomie : ils déterminent eux-mêmes le moment opportun pour agir en fonction du contexte, des objectifs et des informations disponibles. C’est cette autonomie qui caractérise l’« IA agentique ». Cette forme particulièrement autonome d’agent IA, qui ouvre de nouvelles possibilités mais soulève également des enjeux inédits en matière de conception, de contrôle et d’usage. Tous les agents IA ne sont pas considérés comme des IA agentiques, bien que la tendance évolue dans cette direction.

Par exemple, un « agent IA agentique » pourrait envoyer de lui-même un message aux clients de manière proactive si l’annonce d’un retard du fournisseur était arrivée.

Dans le contexte européen, une telle autonomie n’est pas interdite, mais elle relève des obligations de supervision humaine et de transparence imposées par l’AI Act (2024). Dans ce cadre, supervision ne signifie pas validation systématique de chaque action, mais capacité à tracer, contrôler et reprendre la main à tout moment.

Le marché mondial des agents IA, agentiques ou non, devrait représenter 47,1 milliards de dollars en 2030, 1,896 milliard de dollars en France en 2030.

Les agents IA s’appuient sur différentes briques d’intelligence artificielle : compréhension de requêtes, recherche d’informations, planification, action dans les systèmes, génération de texte. Parmi ces briques, les modèles de langage (LLM) imposants jouent un rôle central, mais sont désormais utilisés par les agents IA de manière autonome, sans intervention humaine.

Les agents IA : vers une hyper automatisation du travail ?

Les agents IA fonctionnent en continu, sans fatigue ni pause. Ils permettent aux organisations d’étendre considérablement leur capacité d’action. À ce titre, ils incarnent la promesse d’une productivité accrue et d’une réduction des coûts.

À lire aussi : Les robots collaboratifs, des collègues de travail comme les autres ?

Mais cette automatisation radicale réactive des craintes anciennes : déqualification, dilution des responsabilités, dépendance technologique, perte de contrôle. Ainsi, 75 % des citoyens français pensent que l’IA détruira plus d’emplois qu’elle n’en créera, et 63 % refusent aujourd’hui de se former à ces outils selon le Labo Société numérique 2024. Aux États-Unis, seuls 23 % des adultes pensent que l’IA améliorera leur façon de travailler, contre 73 % des experts de l’IA.

La rupture est donc aussi sociale que technologique.

Les agents d’IA permettront-ils d’innover davantage ?

Automatiser les processus peut figer une manière de faire, plutôt que d’innover. Selon Erik Brynjolfsson, le véritable potentiel de l’IA réside dans son pouvoir d’augmenter les capacités humaines pour faire de nouvelles choses, pas de les remplacer.

Ainsi, plutôt que de remplacer les humains, les agents IA pourraient élargir leur champ d’action créatif. Ils pourraient par exemple suggérer des idées nouvelles, automatiser l’exploration de variantes ou tester rapidement des pistes qu’un humain seul n’aurait pas le temps d’examiner. Cela pourrait ouvrir la voie à des avancées majeures, notamment dans le domaine de la biomédecine.

Mais, pour cela, il faut qu’ils soient dignes de confiance. Le fait que 93 % des employés de bureau doutent encore de la fiabilité des résultats produits par l’IA relève d’un problème d’adoption : cette méfiance renvoie à des failles concrètes des systèmes actuels, qu’il s’agisse d’erreurs, de biais, ou d’un manque de traçabilité et d’explicabilité.

Quelle responsabilité pour les agents d’IA ?

Face à des systèmes capables d’agir de manière autonome tout en faisant des erreurs, qu’il s’agisse de biais, de décisions inadaptées ou d’hallucinations, une question demeure : qui est responsable du résultat ?

Les agents, par nature, ne peuvent ressentir ni assumer la responsabilité de leurs actes.

Pourtant, leur rôle peut rester invisible aux yeux des utilisateurs : les employés peuvent ignorer qu’un agent a pris une décision à leur place, ou se retrouver démunis face à un raisonnement biaisé qu’ils ne comprennent pas.

Un autre risque tient à l’imprécision des consignes données par l’utilisateur, ou à la manière dont l’agent les comprend. Une interprétation erronée peut amener ce dernier à sélectionner un outil inadéquat ou à en faire un usage détourné, avec des effets indésirables. Ce type de dérive est parfois qualifié d’ « hallucination d’appel de fonction ». Enfin, une étude publiée dans Nature montre que les agents IA sont plus enclins que les humains à suivre des instructions manifestement non éthiques, ce qui demande la mise en place de garde-fous prohibitifs. Lorsque les agents travaillent en mode agentique, en toute autonomie et auto-orchestration, ces questions ont d’autant plus de poids.

Ce sont donc les organisations qui doivent prendre l’initiative de mettre en place des mécanismes de gouvernance robustes, pour assurer à la fois la conformité éthique des usages et le bien-être des salariés exposés à ces systèmes. Les actions des agents IA peuvent aussi des conséquences imprévues, dont les organisations restent responsables, ce qui impose de se doter d’un cadre de gouvernance adéquat. Cela suppose des actions concrètes : une gouvernance robuste de l’IA dans l’entreprise, un niveau suffisant de transparence, et des cadres réglementaires établis.

Concrètement, il est essentiel de définir explicitement les responsabilités respectives des humains et des machines, et de former les employés — notamment à la littératie algorithmique — pour leur permettre d’agir en connaissance de cause. Il faut également permettre une collaboration contradictoire, avec un agent IA qui interroge et affine les recommandations de l’agent humain.

D’un point de vue technique, le recours à des audits indépendants et la mise en place de dispositifs d’alerte en cas de dysfonctionnement constituent des garanties indispensables pour un contrôle pertinent des agents IA.

Collaborer… sans humains ? Les limites d’un avenir de systèmes multiagents

Certaines entreprises envisagent de faire collaborer plusieurs agents IA spécialisés pour atteindre des objectifs communs : ce sont les systèmes multiagents. Par exemple, des agents IA pourraient collaborer pour suivre votre réclamation client sur votre dernière commande en ligne, faire des recommandations, remonter la solution, et ajuster votre facture.

Pour y arriver, il reviendra à l’entreprise de bien orchestrer la collaboration entre les agents IA. Elle peut créer un réseau centralisé, avec un serveur qui contrôle les actions et informations des agents et qui peut prendre la main sur le système ; ou alternativement, un réseau décentralisé où les agents IA contrôlent leurs interactions entre eux. Outre les risques d’échec de coordination, l’organisation peut être confrontée à des conflits informationnels entre agents IA et des collusions, et des risques de sécurité.

Plus l’autonomie des agents est élevée, plus il devient essentiel de maintenir une forme de contrôle sur les tâches accomplies.

Le règlement européen sur l’intelligence artificielle insiste sur l’importance qu’un humain dans la boucle puisse intervenir pour corriger, interrompre ou valider les actions de l’IA.

Mais le marché de l’agentique propose une autre solution. Des agents gardiens qui peuvent surveiller, guider, et intervenir dans le comportement des autres agents lorsque nécessaire. Ces agents-gardiens, ou contremaîtres, représenteraient 10 à 15 % du marché de l’IA agentique.

Faut-il alors imaginer un avenir où les humains deviendraient les contrôleurs des contrôleurs ?

Or, ce rôle de supervision sans implication directe dans l’action est loin d’être satisfaisant : il est souvent associé à une baisse de l’engagement et de l’épanouissement professionnel. Pire encore, plus nous déléguons les tâches formatrices à des systèmes automatisés, plus il devient ardu pour les humains d’intervenir efficacement lorsque l’IA échoue, faute d’entraînement ou de compréhension fine de la tâche.

La prochaine fois que vous engagerez une nouvelle tâche… prenez un instant pour vous demander : est-ce vous qui l’accomplirez encore d’ici peu, ou un agent IA à votre place ? Surtout, en quoi cela changerait-il le sens que vous tirerez de votre travail ? À mesure que les agents IA s’installent dans nos outils et nos échanges, c’est toute la société qui doit décider de ce qu’elle souhaite déléguer… et de ce qu’elle préfère préserver.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

SYNTHESE / NOTEBOOKLM

L'article de Stéphanie Gauttier, professeure associée en systèmes d'information, explore la montée en puissance des agents d'intelligence artificielle (IA) dans le milieu professionnel. Il définit ces agents comme des logiciels semi-autonomes capables de prendre des décisions et d'accomplir des tâches, tout en soulignant que cette IA agentique transformera profondément nos méthodes de travail, avec des estimations prévoyant une augmentation significative des décisions professionnelles prises par l'IA d'ici 2028. Le texte aborde les promesses d'hyperautomatisation et de productivité accrue. Dans le même temps, il soulève des préoccupations sociétales majeures concernant la perte d'emplois, le besoin de supervision humaine, la responsabilité éthique des actions de l'IA et la nécessité d'une gouvernance robuste pour encadrer leur utilisation. Il examine également les défis de la collaboration multi-agents et conclut que la société doit décider ce qu'elle souhaite déléguer aux systèmes autonomes et ce qu'elle souhaite préserver en termes de sens du travail humain.

Commentaire

Intelligence Artificielle et Médecine

https://larevuedupraticien-dpc.fr/ia-medecine-generale/

-

IA = outil d’augmentation, pas de remplacement : elle assiste le jugement clinique et la relation médecin-patient.

-

Usages clés en MG : aide au diagnostic (repérage précoce), tri/structuration du DMP, télésurveillance via objets connectés, automatisation administrative (comptes-rendus, planning).

-

Bénéfices attendus : gain de temps médical, réduction de certaines erreurs, parcours plus personnalisés et meilleur suivi des patients complexes, appui à la formation continue.

-

Points de vigilance : fiabilité et biais algorithmiques, transparence/expliquabilité, protection des données (RGPD/HDS), responsabilité juridique, acceptabilité par les patients.

-

Passer à l’action : se former (DPC, MOOC), tester les intégrations dans les logiciels métiers, collaborer avec les acteurs du numérique en santé… tout en préservant la relation humaine et la décision médicale.

Panorama de l’IA dans le secteur médical

Concepts fondamentaux

L’intelligence artificielle appliquée à la santé désigne l’ensemble des technologies capables d’analyser, d'apprendre et d'interpréter des données médicales (cliniques, biologiques, radiologiques, génétiques issues de différents objets connectés), afin d’assister les professionnels de santé dans leurs décisions.

Concrètement, elle repose sur :

- Le machine learning (apprentissage automatique) : c’est-à-dire des algorithmes qui apprennent à reconnaître des schémas à partir de grandes quantités de données (ex : détecter une tumeur sur une radiographie).

- Le deep learning (apprentissage profond) : des réseaux neuronaux sont capables de traiter des images, du son ou du langage naturel avec un haut niveau de précision.

- Et plus largement toutes les applications qui aident à diagnostiquer, surveiller, prédire, traiter ou organiser les soins.

Pour résumer, l’IA analyse des milliers d’images, compare des millions de dossiers, et repère des signaux faibles invisibles à l’œil humain.

Mais l’IA n’est pas un médecin virtuel. C’est un outil complémentaire qui permet d’augmenter les capacités des soignants (rapidité, précision, personnalisation des soins), sans se substituer à leur jugement clinique et à la relation humaine qu’il noue avec le patient au fil des consultations.

Domaines d’application généraux

On la retrouve en :

- Chirurgie robotisée, avec des systèmes comme da Vinci Xi® qui offrent des gestes d’une très grande précision avec des incisions minimes.

- Radiologie: Gleamer, Milvue et Incepto Medical développent des algorithmes capables de détecter des fractures, des nodules (pulmonaires), des lésions précancéreuses et autres anomalies précoces.

- Oncologie, des entreprises comme Owkin croisent des données cliniques et génétiques pour proposer des traitements personnalisés.

- Pathologie: Primaa analyse automatiquement des lames biologiques en laboratoire.

- Médecine générale, Kaduceo ou Posos assistent les praticiens dans la vérification de leurs diagnostics (diagnostic assisté par IA).

- Médecine prédictive : identification des patients à risque avant l’apparition des symptômes.

- Pharmacies : gestion prédictive des stocks, anticipation des ruptures.

- Et chez les assureurs santé : ajustement des primes et programmes de prévention via l’

Enjeux

Les promesses sont nombreuses : personnalisation des soins, adaptation des traitements aux profils des patients, amélioration de la qualité des soins, baisse des erreurs médicales, libération du temps médical grâce à l’automatisation des tâches répétitives et chronophages.

Mais elles s’accompagnent d’interrogations sur la fiabilité, l’éthique et la place de l’humain.

Rappelons une fois de plus que l'IA en médecine est pour l'instant un OUTIL et rien de plus.

Au total AGENT IA en MÉDECINE, PRUDENCE et RÉFLEXION, ÉTHIQUE et HUMANITÉ, la SOLUTION au manque de MÉDECINS… peut-être, mais à la condition d'en conserver la maîtrise.

L'HUMAIN dans cette histoire garde ses prérogatives médicales. Par contre la DELEGATION de tâches, OUI...sous surveillance humaine...tout au moins pour l'instant !

NEWS DOCTOLIB et son ASSISTANT IA

Les principales fonctionnalités de l'assistant médical basé sur l'IA de Doctolib sont les suivantes :

Répondre aux questions des patients avec expertise : L'assistant fournira des réponses basées sur des connaissances validées par des soignants et chercheurs français.

* Fournir du contenu sur-mesure : Il proposera des informations personnalisées pour aider les patients à prendre soin de leur santé, notamment sur la prévention, la vaccination et le dépistage.

* Suivi de la santé : L'outil permettra aux patients de suivre leur santé de manière plus efficace et complète, ainsi que de partager leurs données.

*Respect des normes de sécurité : Les services respecteront les normes de sécurité françaises et européennes ainsi que le parcours de soins, sans fournir de diagnostic ni de prescription.

Ces fonctionnalités visent à lutter contre les fausses informations en santé et à offrir un accompagnement éthique et rigoureux scientifiquement.

A VOIR A L'USAGE par les PATIENTS

Copyright : Dr Jean-Pierre Laroche / 2025

-