https://institut-superieur-environnement.com/blog/lintelligence-artificielle-une-pollution-cachee-au-coeur-de-linnovation/

IA ENERGIVORE ?

https://institut-superieur-environnement.com/blog/lintelligence-artificielle-une-pollution-cachee-au-coeur-de-linnovation/

En 2023, une requête sur ChatGPT était estimée à environ 3 Wh soit l’équivalent de dix recherches classiques sur Google. Mais, dès 2025, une étude plus récente a revu ce chiffre à la baisse, le ramenant à seulement 0,3 Wh — juste assez pour faire bouillir 3 millilitres d’eau chaude, moins d’une cuillère à café.

À ce sujet, fin juillet, la startup française Mistral, pionnière dans le domaine, a partagé ses propres données, estimant l’impact carbone de son modèle à 1,14 gramme de CO₂ par requête. Ces chiffres soulignent non seulement la diversité des approches, mais aussi les progrès constants qui redessinent le paysage énergétique de l’IA.

(GPU), chacune consommant de 400 à 700 watts. En pic d’activité, cette infrastructure pourrait avaler jusqu’à 35 mégawatts. En juin 2025, l’entreprise de Sam Altman accueille quotidiennement environ 125 millions d’utilisateurs, générant un milliard de requêtes. Dans le scénario le plus pessimiste, cela équivaut à

d’un réacteur nucléaire.

Par exemple, les chercheurs chinois de DeepSeek ont fait sensation début 2025 avec leur modèle R1, d’une envergure comparable à celui d’OpenAI, mais entraîné pour un budget vingt fois inférieur de 5,6 millions de dollars.

Ces bonds en avant algorithmiques sont monnaie courante en informatique, démontrant que l’efficacité peut primer sur la force brute. Enfin, ne perdez pas de vue l’ensemble du tableau : ces entraînements coûteux sont amortis sur un volume colossal d’utilisations quotidiennes, rendant leur part relative dans l’impact global bien plus modeste qu’il n’y paraît.

Résultat : une interrogation médiane ne demande plus que 0,24 Wh. Ces progrès illustrent le potentiel infini de l’innovation pour atténuer les coûts énergétiques.

.

L’IA pèse également peu dans nos habitudes quotidiennes et elle pourrait même nous aider à économiser de l’énergie en automatisant des tâches chronophages, libérant ainsi du temps et des ressources pour des activités plus efficientes. Pas bête, non ?

L'IA frugale, tel est l'enjeu de sa consommation énergétique.

L'IA peut-elle diriger elle-même cette consommation énergétique et la diminuer, voire l'annihiler ?

L'IA a un autre défaut : son coût.

Mais, cependant, elle a beaucoup d'avantages, notamment en médecine et dans mille autres domaines.

Alors, œuvrons et encore œuvrons pour une IA FRUGALE.

Est-ce une boite de Pandore ? Pas exactement , ne pas oublier cette citation : “Comprendre est le commencement d'approuver.” Baruch Spinoza

Militons pour une IA apaisée à la condition que les humains ne la transforment en machine de guerre !

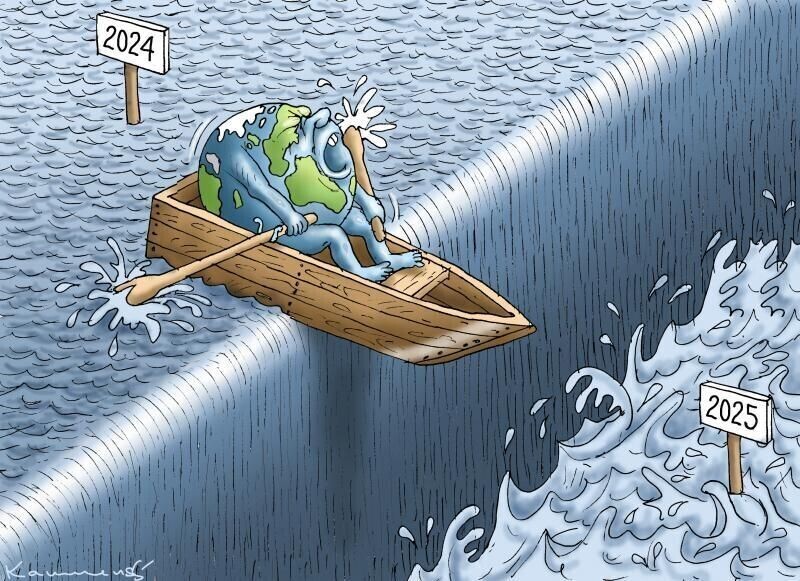

Peut-on faire confiance aux humains dans cette période chaotique où ils sont à l'origine même de ce chaos ?

C'est que l'homme est capable de tout , du bien comme du mal.

L'IA créée par l'homme aura-t-elle le même avenir que l'homme ?

L'IA sera capable demain d'une autorégulation en matière de consommation d'énergie et d'eau.

Une IA nommée Perplexity donne son avis sur la consommation d'énergie de l'intelligence artificielle.

La limitation de la consommation énergétique majeure de l'IA est devenue un enjeu prioritaire et plusieurs pistes concrètes sont identifiées pour rendre l'intelligence artificielle moins énergivore.

Optimisation des modèles et des algorithmes

-

L'utilisation de modèles plus petits, ciblés sur des tâches spécifiques (traduction, synthèse, etc.), permet de réduire jusqu'à 90% la consommation d'énergie par rapport aux grands modèles polyvalents.

-

Des techniques comme la compression des modèles, la quantification et l'élevage des réseaux de neurones (data pruning, quantization) réduisent la charge informatique et donc le coût énergétique.

Améliorations matérielles et infrastructures

-

L'adoption de puces plus économes et de serveurs optimisés (hardware efficient), ainsi que l'implantation géographique des centres de données dans des zones à climat tempéré et à proximité de sources d'énergie renouvelables, permettent de limiter la consommation électrique et le besoin en refroidissement.

-

L'informatique neuromorphique, inspirée du cerveau humain, vise à rapprocher le stockage et le traitement des données, ce qui réduit les échanges énergivores et améliore l'efficacité globale des systèmes d'IA.

Stratégies d'usage et de sobriété

-

Prioriser l'utilisation de l'IA pour des tâches ayant une réelle valeur ajoutée et éviter son recours pour des opérations simples pouvant être traitées par des systèmes classiques moins énergivores.

-

Optimiser la formulation des requêtes et limiter les interactions prolongées et non nécessaires avec les outils d'IA générative.

-

Privilégier les fournisseurs d'IA ayant une démarche environnementale, notamment une alimentation en énergie renouvelable, et sensibiliser les utilisateurs et professionnels à l'impact énergétique de leurs usages.

Responsabilité collective et innovation

-

Les entreprises doivent inclure la sobriété numérique dans leur politique RSE, et exiger de leurs fournisseurs cloud des garanties sur l'utilisation d'énergie verte.

-

Les chercheurs encouragent la publication de données sur l'empreinte carbone de l'IA et promettent l'innovation vers des architectures plus frugales.

Un changement global des pratiques et une rationalisation des usages s'imposent pour éviter que la consommation énergétique de l'IA aggrave la crise environnementale actuelle.

THE SHIFT PROJECT et IA

https://theshiftproject.org/app/uploads/2025/04/2025_03_06-TSP-Rapport-intermediaire-IA-quelles-infra-num-monde-decarbone.pdf

IA et son empreinte carbone

https://medvasc.info/archives-blog/ia-%C3%A9nergie

IA : bombe ou levier écologique.

https://medvasc.info/archives-blog/ia-bombe-ou-levier-%C3%A9cologique

CONCLUSION

@Laure_Esmeralda

@Laure_EsmeraldaCopyright : Dr Jean Pierre Laroche / 2025