"L’aspect le plus triste de notre vie aujourd’hui est que la science acquière les connaissances plus vite que la société n’acquière la sagesse." Issac Asimov

L'IA peut-elle être surhumaine ? Des failles dans les meilleurs robots de jeu jettent le doute. Construire des systèmes d'IA robustes qui surpassent toujours les humains pourrait être plus difficile qu'on ne le pensait, affirment les chercheurs qui ont étudié les robots jouant au Go.

Nature. 2024 Jul 8. doi: 10.1038/d41586-024-02218-7. Epub ahead of print. PMID: 38977931.https://www.nature.com/articles/d41586-024-02218-7

Les rumeurs sur l'intelligence artificielle (IA) surhumaine sont de plus en plus nombreuses.

Mais des recherches ont révélé des faiblesses dans l'un des systèmes d'IA les plus performants - un robot qui joue au jeu de société Go et peut battre les meilleurs joueurs humains du monde - montrant qu'une telle supériorité peut être fragile. L'étude soulève des questions sur la possibilité que des systèmes d'IA plus généraux souffrent de vulnérabilités qui pourraient compromettre leur sécurité et leur fiabilité, voire leur prétention à être « surhumains ».

« Ce document laisse planer un doute important sur la manière d’atteindre l’objectif ambitieux de créer des agents d’IA robustes et fiables dans le monde réel », déclare Huan Zhang, informaticien à l’Université de l’Illinois à Urbana-Champaign. Stephen Casper, informaticien au Massachusetts Institute of Technology de Cambridge, ajoute : « Il fournit l’une des preuves les plus solides à ce jour qu’il est difficile de faire en sorte que des modèles avancés se comportent de manière robuste comme souhaité. »

L'analyse, qui a été publiée en ligne sous forme de prépublication le 1er juin et n'a pas été évaluée par des pairs, utilise ce que l'on appelle des attaques antagonistes : elles alimentent les systèmes d'IA avec des entrées conçues pour inciter les systèmes à commettre des erreurs , soit à des fins de recherche, soit à des fins malveillantes. Par exemple, certaines invites peuvent « jailbreaker » les chatbots, les obligeant à divulguer des informations nuisibles qu'ils ont été formés à supprimer.

Au Go, deux joueurs placent à tour de rôle des pierres noires et blanches sur une grille pour entourer et capturer les pierres de l'autre joueur. En 2022, des chercheurs ont rapporté avoir entraîné des robots d'IA adverses à vaincre KataGo , le meilleur système d'IA open source pour jouer au Go, qui bat généralement les meilleurs humains facilement (et sans coup férir). Leurs robots ont trouvé des exploits qui battent régulièrement KataGo, même s'ils n'étaient pas très bons par ailleurs - des amateurs humains pouvaient les battre. De plus, les humains pouvaient comprendre les astuces des robots et les adopter pour battre KataGo.

Exploiter KataGo

S’agissait-il d’un cas isolé ou ces travaux ont-ils mis en évidence une faiblesse fondamentale de KataGo – et, par extension, d’autres systèmes d’IA dotés de capacités apparemment surhumaines ?

Pour mener leur enquête, les chercheurs, dirigés par Adam Gleave, directeur général de FAR AI, une organisation de recherche à but non lucratif basée à Berkeley, en Californie, et co-auteur de l’article de 2022 , ont utilisé des robots antagonistes pour tester trois façons de défendre les IA Go contre de telles attaques .

La première défense était celle que les développeurs de KataGo avaient déjà déployée après les attaques de 2022 : donner à KataGo des exemples de positions de l’échiquier impliquées dans les attaques et lui faire jouer lui-même pour apprendre à jouer contre ces positions. C’est similaire à la façon dont il a appris à jouer au Go de manière plus générale. Mais les auteurs du dernier article ont découvert qu’un robot adverse pouvait apprendre à battre même cette version mise à jour de KataGo, gagnant 91 % du temps.

La deuxième stratégie défensive que l'équipe de Gleave a essayée était itérative : entraîner une version de KataGo contre des robots adverses, puis entraîner les attaquants contre la version mise à jour de KataGo, et ainsi de suite, pendant neuf tours. Mais cela n'a pas non plus abouti à une version imbattable de KataGo. Les adversaires ont continué à trouver des exploits, le dernier ayant battu KataGo dans 81 % des cas.

En guise de troisième stratégie défensive, les chercheurs ont formé un nouveau système d’IA pour jouer au Go à partir de zéro. KataGo est basé sur un modèle informatique connu sous le nom de réseau neuronal convolutionnel (CNN). Les chercheurs soupçonnaient que les CNN pouvaient trop se concentrer sur les détails locaux et passer à côté des modèles globaux, ils ont donc construit un joueur de Go en utilisant un réseau neuronal alternatif appelé transformateur de vision (ViT). Mais leur robot antagoniste a trouvé une nouvelle attaque qui lui a permis de gagner 78 % du temps contre le système ViT.

Des adversaires faibles

Dans tous ces cas, les robots adverses, bien que capables de battre KataGo et d'autres systèmes de jeu de Go de premier plan, ont été entraînés à découvrir les vulnérabilités cachées d'autres IA, et non à devenir des stratèges chevronnés. « Les adversaires sont encore assez faibles, nous les avons battus nous-mêmes assez facilement », déclare Gleave.

Et si les humains sont capables d’utiliser les tactiques des robots adverses pour vaincre les systèmes d’IA experts de Go, est-il encore judicieux de qualifier ces systèmes de surhumains ? « C’est une excellente question à laquelle je me suis vraiment attaqué », déclare Gleave. « Nous avons commencé à dire « typiquement surhumains ». David Wu, informaticien à New York qui a été le premier à développer KataGo, affirme que les IA Go fortes sont « surhumaines en moyenne », mais pas « surhumaines dans le pire des cas ».

Selon Gleave, ces résultats pourraient avoir de vastes implications pour les systèmes d’IA, notamment pour les grands modèles de langage qui sous-tendent les chatbots tels que ChatGPT . « Le principal enseignement pour l’IA est que ces vulnérabilités seront difficiles à éliminer », explique Gleave. « Si nous ne parvenons pas à résoudre le problème dans un domaine simple comme Go, il semble peu probable à court terme de corriger des problèmes similaires comme les jailbreaks dans ChatGPT. »

Selon Zhang, les résultats de cette étude ne permettent pas de déterminer avec certitude si l’IA pourrait être capable de surpasser les capacités humaines.

« Bien que cela puisse suggérer que les humains pourraient conserver un certain temps des avantages cognitifs importants sur l’IA, je pense que le point le plus important à retenir est que nous ne comprenons pas pleinement les systèmes d’IA que nous construisons aujourd’hui . »

doi: https://doi.org/10.1038/d41586-024-02218-7

Commentaire

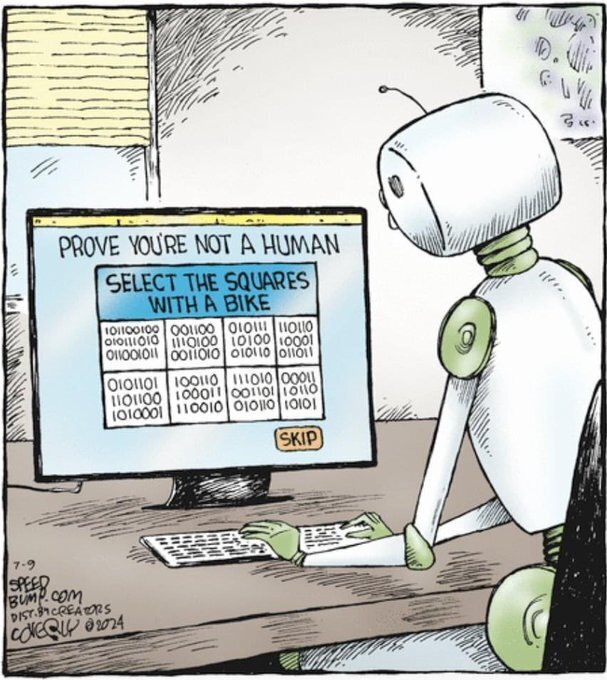

La course à l'évolution de l'IA doit être maîtrisée par l'humain et non le contraire. On doit rester dans la science et ne pas s'échapper dans la science fiction , attention danger !

A RELIRE

IA et Machiavel : retour aux sources

https://medvasc.info/archives-blog/ia-et-machiavel-retours-aux-sources?highlight=WyJtYWNoaWF2ZWwiXQ==