" La nuance est le luxe de l’intelligence libre. Albert Camus

IA : utilisation responsable

https://jamanetwork.com/journals/jama/fullarticle/2842278?guestAccessKey=61e37f76-0a1d-447a-a2a7-a5905ebfb924&utm_medium=email&utm_source=postup_jn&utm_campaign=article_alert-jama&utm_content=etoc-tfl_&utm_term=012026

Article en libre accès

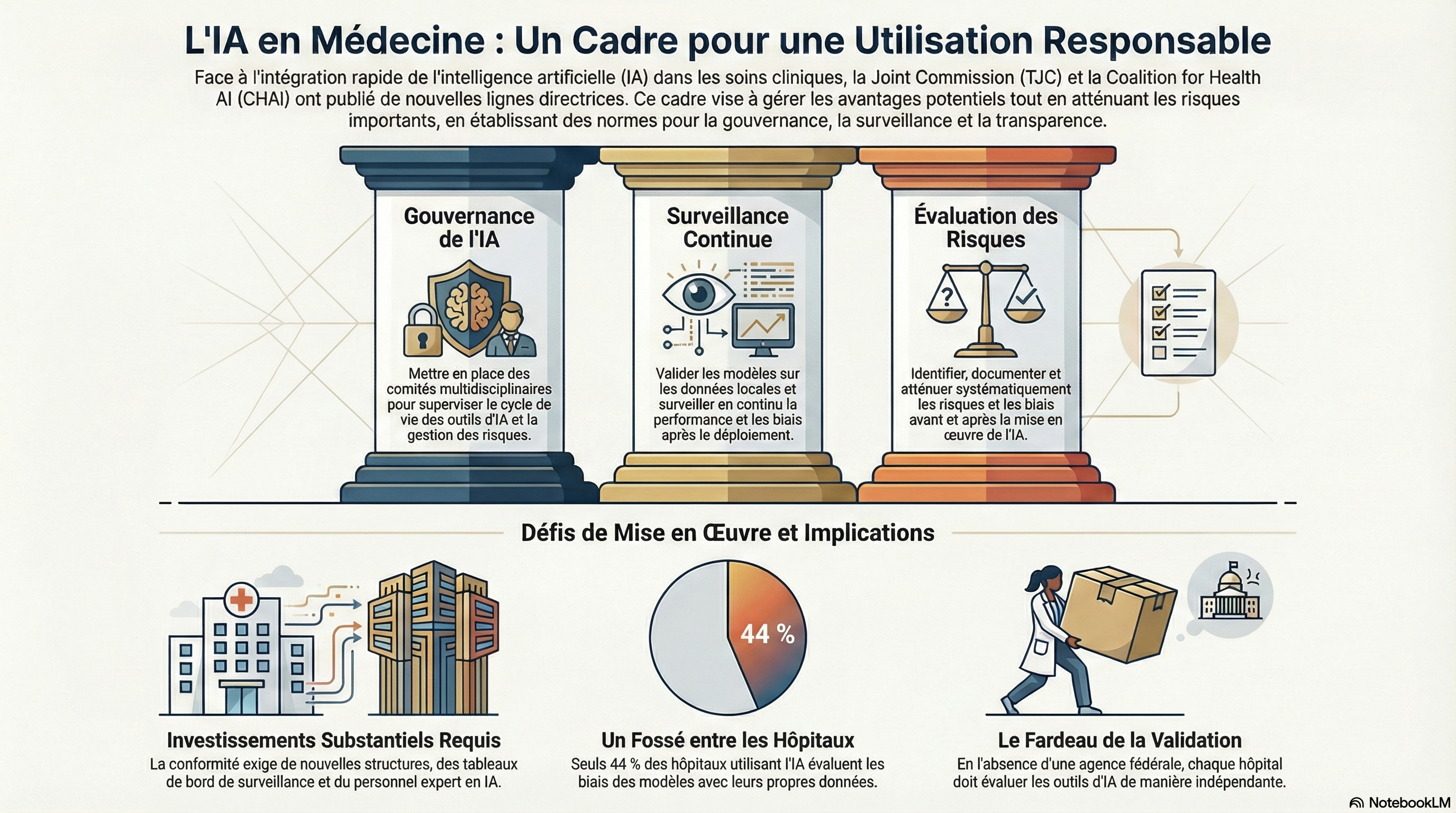

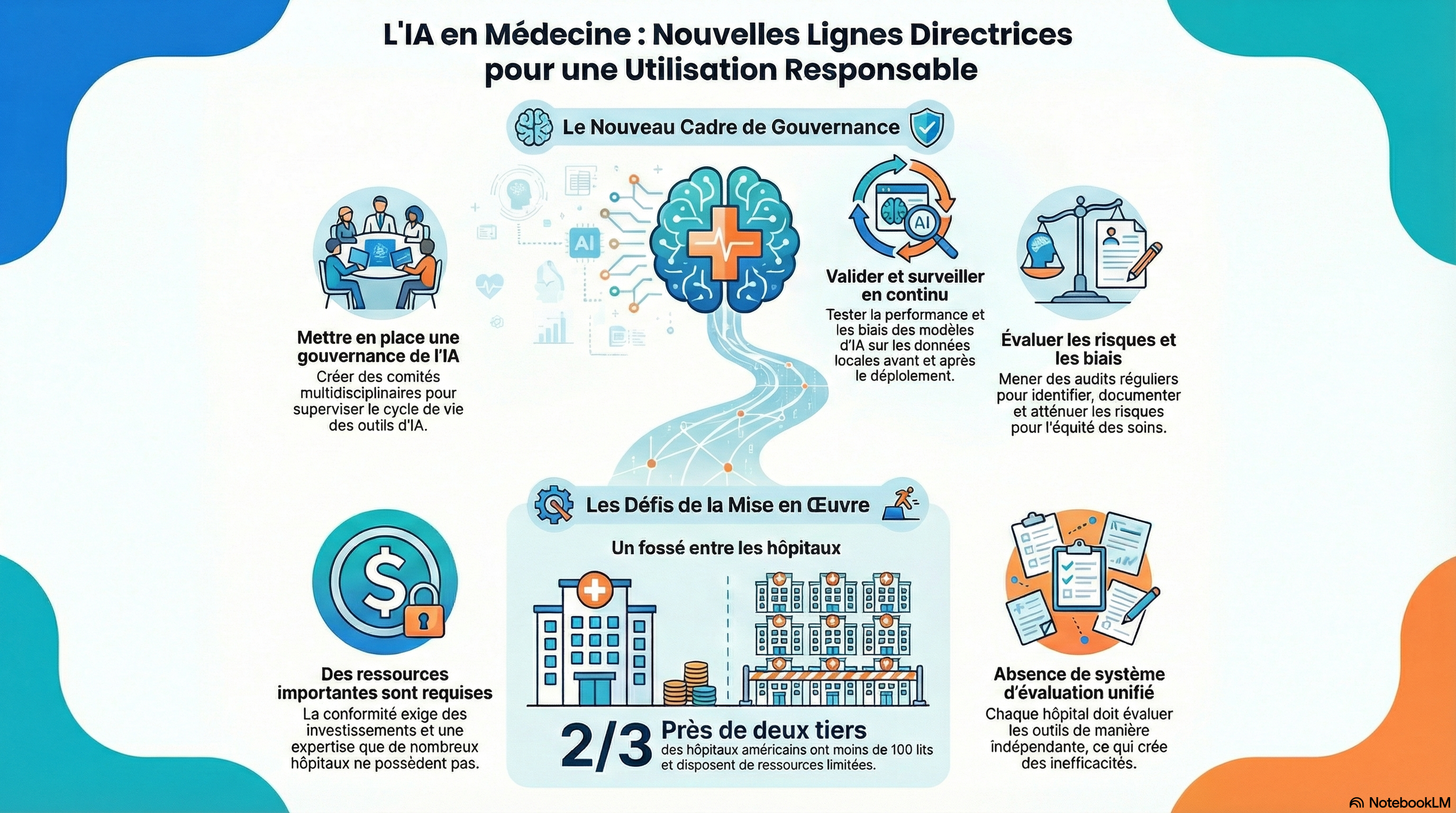

L'intelligence artificielle (IA) est rapidement passée à l'application clinique, comme l'imagerie et d'autres diagnostics, le scribing environnemental et l'aide à la décision. Il a apporté à la fois des avantages potentiels et des risques importants.

Aux États-Unis, il n'est pas clair qui a la responsabilité d'établir les règles, de valider les modèles et, en fin de compte, de payer en cas de problème.

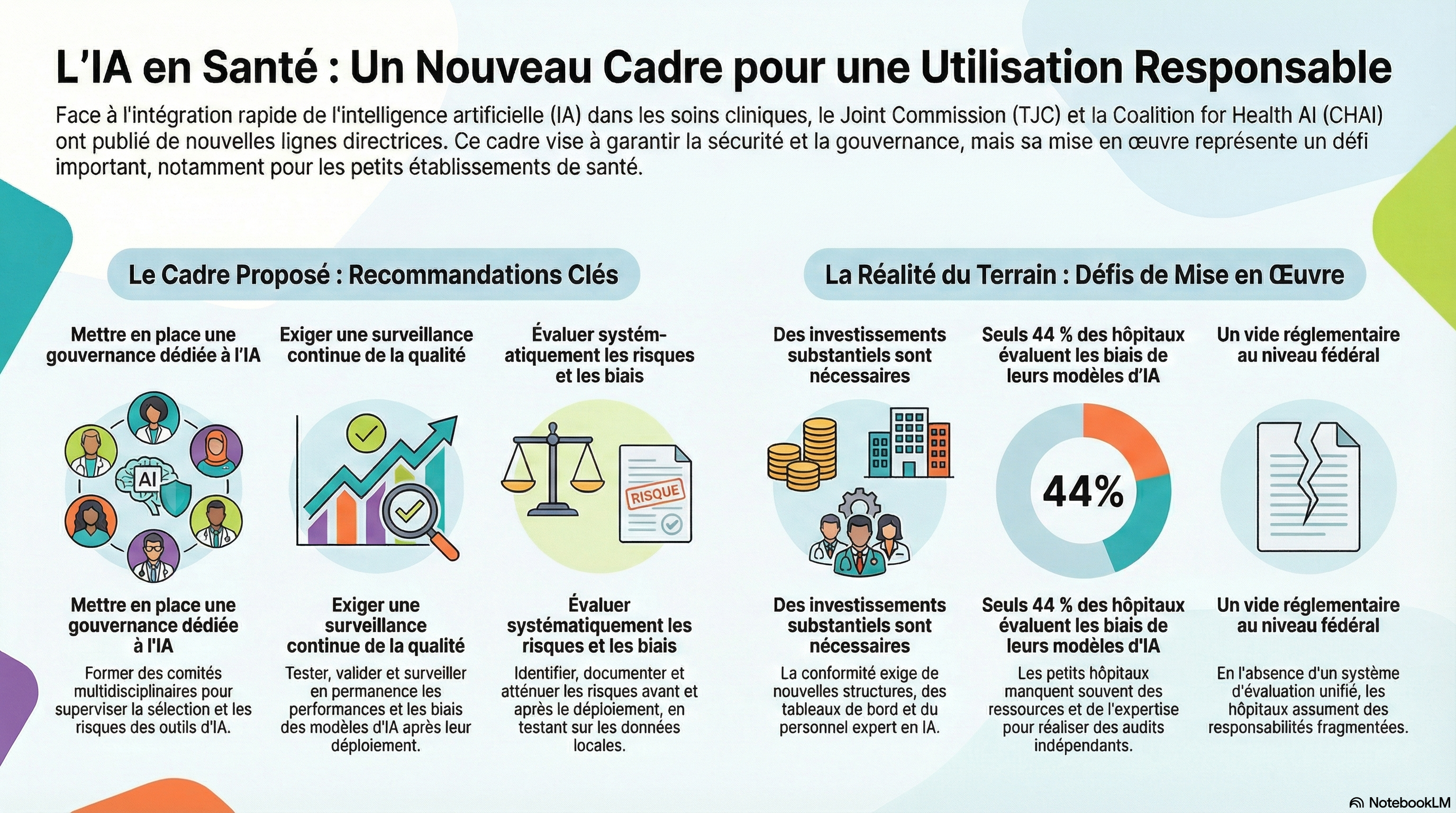

Dans ce contexte, la Commission mixte (TJC, le principal accréditeur d'hôpital américain) s'est associée à la Coalition for Health AI (CHAI, un groupe dirigé par des cliniciens qui comprend l'industrie et les parties prenantes).

Ensemble, ils ont publié de nouvelles directives sur l'utilisation responsable de l'IA dans les soins de santé,qui s'appuient sur des déclarations antérieures de nombreux groupes, y compris l'American Medical Association.

Les principales recommandations comprennent la création de comités multidisciplinaires de gouvernance de l'IA, la validation de modèles sur les données et les flux de travail locaux des patients avant le déploiement et l'institution d'une surveillance continue après la mise sur le marché pour la dérive, la dégradation des performances ou les biais.

| Titre de la ligne directrice citée | Exigences clés paraphrasées |

|---|---|

| Politiques d'IA et structures de gouvernance |

Exiger une expertise et une représentation interfonctionnelle (leadership, informatique, conformité, cliniciens, sécurité, confidentialité) Superviser la sélection, le cycle de vie, la conformité et la gestion des risques des outils d'IA Signaler les activités de l'IA et les événements indésirables au conseil d'administration |

| Confidentialité et transparence des patients |

Établir des politiques d'accès, d'utilisation et de protection des données conformes à la loi HIPAA et de l'État Divulguer et éduquer les patients sur l'utilisation de l'IA affectant leurs soins ; obtenir le consentement le cas échéant |

| Protections de la sécurité des données et de l'utilisation des données |

Crypter les données en transit et au repos Appliquer des contrôles d'accès stricts et des journaux d'audit Effectuer des évaluations régulières de sécurité et maintenir un plan d'intervention en cas d'incident |

| Surveillance continue de la qualité |

Exiger que les fournisseurs fournissent des données de validation et de test de biais Tester, valider et surveiller en permanence les performances et les biais de l'IA après le déploiement Étaler la fréquence de surveillance à la proximité du risque avec les soins aux patients |

| Rapports volontaires et aveugles d'événements liés à la sécurité de l'IA |

Mettre en œuvre des rapports confidentiels et dépersonnalisés des événements de sécurité de l'IA à des entités indépendantes Intégrer les incidents d'IA dans les systèmes de rapports de sécurité existants |

| Évaluation des risques et des préjugés |

Identifier, documenter et atténuer les risques et les biais avant et après le déploiement Demander des données de biais du fournisseur et des cartes modèles Utiliser des ensembles de données de formation et de validation représentatifs ; tester sur des données locales Effectuer des audits réguliers de biais |

| Éducation et formation |

Fournir une formation en IA spécifique au rôle pour les cliniciens et le personnel Assurer la documentation et les conseils sur chaque outil d'IA |

Les directives du CHAI et du TJC laissent de nombreux détails aux organisations de soins de santé à opérationnaliser.

Par exemple, il semble prendre une ligne étonnamment dure sur l'engagement avec les patients, conseillant que "[si]when approprié, les patients devraient être informés lorsque l'IA a un impact direct sur leurs soins.... Le cas échéant, le consentement doit être obtenu. »

Les médecins ne divulguent généralement pas ou ne demandent pas leur consentement pour chaque appareil technologique qu'ils peuvent déployer (par exemple, ce scalpel contre celui-là). L'IA est-elle différente en nature ?

Chaque rapport de radiologue a-t-il besoin d'une clause de non-responsabilité concernant l'utilisation de l'IA ou même d'un préconsent pour cette utilisation ?

Que font les patients de telles divulgations ? 2 Les questions difficiles persistent dans les mots de la ligne directrice appropriés et pertinents.

Pour les établissements de soins de santé, le respect des nouvelles directives nécessitera des structures de gouvernance, des tableaux de bord de surveillance, des mécanismes de déclaration des incidents et de la documentation.Ces mesures parallèlement aux cadres de qualité et de sécurité établis (tels que les exigences d'accréditation, les rapports sur les événements de sécurité des patients et les programmes de gestion des risques) afin que la surveillance de l'IA puisse être intégrée dans des structures déjà familières aux hôpitaux.

Cependant, la conformité nécessitera vraisemblablement de nouveaux investissements substantiels.

TJC et CHAI appellent chaque hôpital à mettre en place une structure de gouvernance formelle pour l'IA, avec des politiques et des procédures pour sélectionner, mettre en œuvre et superviser les outils d'IA. Cette fonction exigera que les cadres ayant une expertise appropriée en matière d'IA rassemblent et dirigent un comité multidisciplinaire d'IA. L'un des éléments les plus gourmands en ressources est peut-être la surveillance continue des performances et des résultats de l'IA.

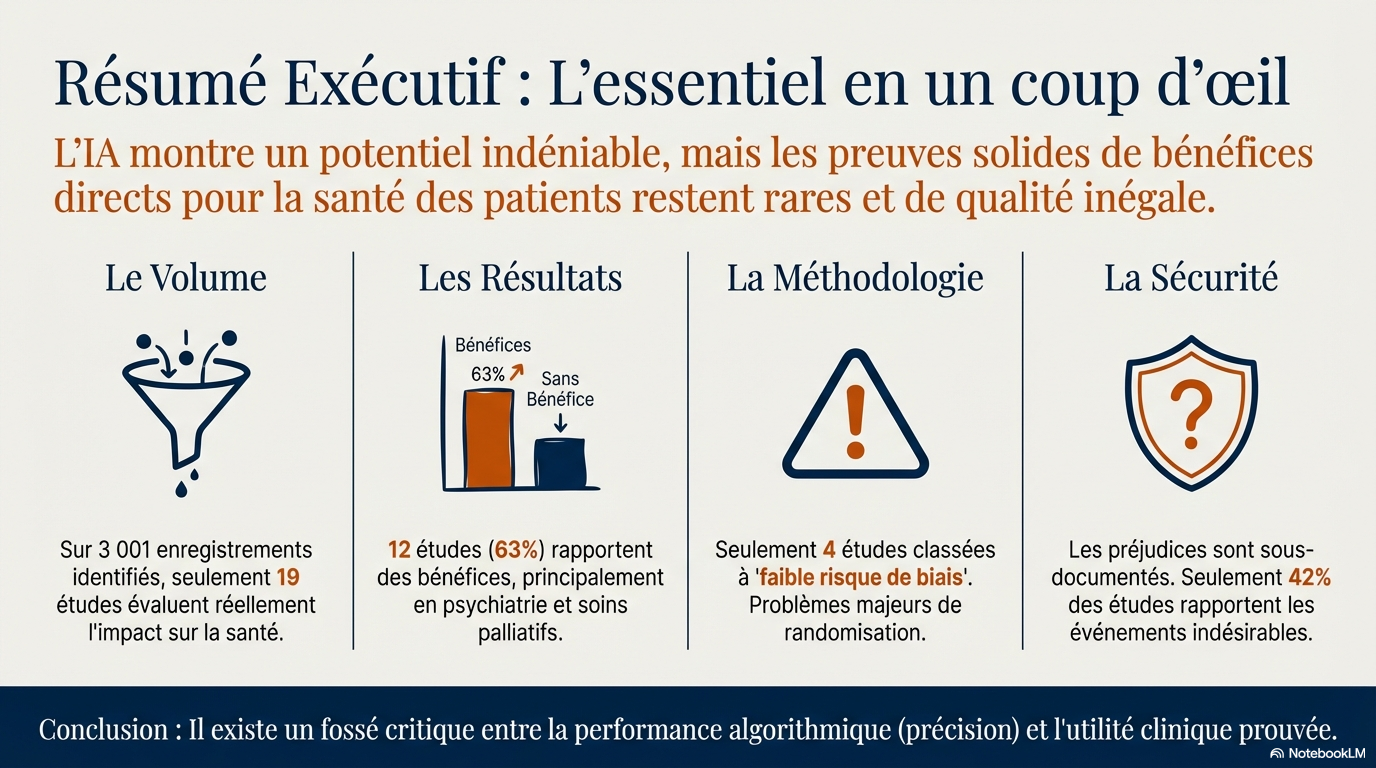

L'hôpital doit mesurer la précision, les erreurs ou les événements indésirables associés aux recommandations d'IA et la performance au fil du temps, y compris l'équité et les préjugés entre les populations de patients. Bien que les grands centres universitaires aient la capacité de valider rigoureusement les outils d'IA, près des deux tiers des hôpitaux américains ont moins de 100 lits, et beaucoup opèrent dans des milieux ruraux avec des contraintes de ressources (par exemple, l'absence de couverture élargie de Medicaid).Un petit hôpital communautaire est plus susceptible de se procurer une technologie prête à l'emploi et à faire confiance aux assurances des fournisseurs. Effectuer un audit indépendant des biais et une analyse des risques pourrait dépasser leur expertise et leurs ressources.

Ces défis expliquent pourquoi la recherche montre que bien que 61 % des hôpitaux utilisant l'IA aient effectué une validation locale pour l'exactitude, seuls 44 % ont évalué leurs modèles pour les biais en utilisant leurs propres données

Pour de nombreux hôpitaux, les directives du CHAI et du TJC peuvent être ambitieuses.

Quelles sont les conséquences de la non-conformité ?

TJC n'a pas (encore) intégré ces normes dans ses exigences d'accréditation, qui sont une condition préalable à la facturation des assureurs publics et privés. Pour l'instant, ces directives affecteront vraisemblablement la responsabilité.

Les tribunaux ont tenu les médecins et les organisations de soins de santé à une norme de soins raisonnable, en partie informée par des conseils persuasifs d'organisations réputées, telles que TJC et CHAI. Un médecin défendeur pourrait utiliser ces directives pour souligner que la responsabilité incombe aux organisations de soins de santé, réduisant ou évitant ainsi la responsabilité du médecin.3 D'autre part, les hôpitaux sont dans une impasse s'ils ne sont pas en mesure de se conformer à des directives onéreuses. Pourtant, les tribunaux peuvent prendre en compte les limites de ressources lors de la responsabilité en cas de négligence.

En plus des préoccupations en matière de distribution qui se répartissent dans les organisations de soins de santé, il existe également des préoccupations plus larges en matière d'efficacité. Est-il logique que chacune des milliers d'organisations de soins de santé fasse tout ce travail de manière indépendante ?

Au contraire, un système rationnel pourrait faire faire une grande partie de ce travail une fois avec autorité. De même, nous ne nous attendons pas à ce que chaque hôpital effectue une évaluation de novo de la compétence de chaque médecin ; au lieu de cela, les comités du personnel hospitalier s'appuient sur les agences d'autorisation de l'État. Pourtant, aucune agence de ce type n'existe actuellement pour l'IA.

Les directives TJC et CHAI tentent de tirer le meilleur parti d'un monde déjà fragmenté, dans lequel le gouvernement fédéral américain n'a pas pris de l'avance pour fournir un mécanisme complet pour évaluer les services d'IA qui sont utilisés dans le commerce interétatique et financés par les programmes fédéraux de soins de santé.À son crédit, le CHAI a également proposé de combler cette lacune en créant un réseau de laboratoires d'assurance privés pour tester les algorithmes afin que les organisations de soins de santé puissent s'y fier. L'administration Biden était alignée sur cette approche, mais l'administration Trump s'y oppose. La préoccupation est qu'une coalition privée, lourde d'industrie, pourrait ancrer les fournisseurs dominants et agir en tant que régulateur de facto.

En partie, l'écart fédéral est créé par une décision de la Food and Drug Administration (FDA) des États-Unis de concentrer son application sur les technologies d'IA automatisées lorsqu'il n'y a pas de médecin dans la boucle. Un budget beaucoup plus important de la FDA serait nécessaire pour atteindre toutes les technologies de soins de santé en matière d'IA, et l'industrie devrait investir massivement pour répondre aux demandes de science dont la FDA aurait besoin. De tels investissements pourraient faire économiser de l'argent pour le système de soins de santé dans son ensemble en réduisant les licenciements locaux et en améliorant la performance globale. À la fin du mois de septembre 2025, la FDA a demandé des commentaires du public sur une nouvelle approche potentielle des « approches pratiques pour mesurer et évaluer la performance des dispositifs médicaux compatibles avec l'IA sur le terrain, y compris des stratégies pour identifier et gérer l'évolution des performances, telles que la détection des changements d'entrée et de sortie ».

En fin de compte, TJC et CHAI ont créé un cadre important visant à améliorer la sécurité des patients, à améliorer les résultats des patients, renforcer la protection des données, accroître la confiance et une plus grande efficacité opérationnelle. Sans un système unifié d'évaluation des produits d'IA, les hôpitaux continueront d'assumer des responsabilités fragmentées, créant des inefficacités et élargissant les disparités en matière de sécurité, de qualité et potentiellement de responsabilité.

Auteur correspondant : Christopher T. Robertson, JD, PhD, Boston University School of Law, 765 Commonwealth Ave, Boston, MA 02215 (

RESUME GENERATIF

Ce document traite des nouvelles directives sur l'utilisation responsable de l'intelligence artificielle (IA) dans le domaine de la santé, émises par la Joint Commission et la Coalition for Health AI.

Directives sur l'utilisation de l'IA

- * L'IA est de plus en plus intégrée dans les soins cliniques, mais elle présente des risques et des incertitudes concernant la responsabilité en cas de problèmes.

- * Les recommandations incluent la création de comités de gouvernance multidisciplinaires, la validation des modèles sur des données locales avant leur déploiement, et la surveillance continue des performances pour détecter les biais et la dégradation.

- * Les établissements de santé doivent établir des structures de gouvernance, des mécanismes de signalement des incidents et des tableaux de bord de surveillance, ce qui nécessite des investissements significatifs.

Engagement des patients et consentement

- * Les directives insistent sur la nécessité d'informer les patients lorsque l'IA influence leur soin et d'obtenir leur consentement lorsque cela est pertinent.

- * Cela soulève des questions sur la nature de l'IA par rapport aux autres technologies médicales, et sur la nécessité d'une divulgation systématique.

Défis de mise en œuvre

- * De nombreux hôpitaux, en particulier les plus petits, peuvent avoir des difficultés à se conformer à ces directives en raison de contraintes de ressources.

- * Bien que 61 % des hôpitaux utilisant l'IA aient validé localement leur précision, seulement 44 % ont évalué les biais.

Conséquences de la non-conformité

- * Les directives n'ont pas encore été intégrées dans les exigences d'accréditation, mais elles pourraient influencer la responsabilité légale des établissements de santé.

- * Les tribunaux pourraient tenir compte des limitations de ressources lors de l'évaluation de la négligence.

Rôle des agences et des laboratoires d'assurance

- * L'absence d'une agence fédérale pour évaluer les services d'IA crée des inefficacités et des disparités dans la sécurité et la qualité des soins.

- La Coalition for Health AI propose de créer des laboratoires d'assurance privés pour évaluer les algorithmes, mais cela soulève des préoccupations sur la domination des fournisseurs.

ANALYSE PDF EXPERT AI

Ce document présente les nouvelles recommandations de la Joint Commission et de la Coalition pour l'IA en santé concernant l'utilisation responsable de l'IA en milieu clinique. Il met en avant des recommandations telles que la gouvernance multidisciplinaire, la validation locale, la surveillance continue et la transparence envers les patients. Il souligne les ressources et l'infrastructure nécessaires aux hôpitaux pour s'y conformer, notamment les tableaux de bord de surveillance, le signalement des incidents et l'expertise de la direction en matière d'IA. Les auteurs examinent les difficultés pratiques rencontrées par les petits hôpitaux, les implications juridiques et de responsabilité potentielles, ainsi que les lacunes de la réglementation fédérale. Ils évoquent les propositions relatives aux laboratoires d'assurance qualité privés, les considérations de la FDA concernant l'évaluation post-commercialisation et les inquiétudes liées à la fragmentation des responsabilités, source d'inefficacité et d'inégalités.

Exigences en matière de notification des patients concernant l'utilisation de l'IA

Les patients doivent être informés de l'utilisation de l'IA dans leurs soins lorsque celle-ci a un impact direct sur ces derniers. Les recommandations de la Coalition pour l'IA en santé (CHAI) et de la Joint Commission (TJC) précisent :

- « Le cas échéant, les patients devraient être informés lorsque l’IA a un impact direct sur leurs soins… Le consentement devrait être obtenu lorsque cela est pertinent. »

Points clés

- Impact direct : une notification est requise lorsque les outils d’IA ont un impact direct sur les décisions ou les résultats relatifs aux soins des patients.

- Pertinence et adéquation : les termes « adéquation » et « adéquation » sont utilisés dans les recommandations, indiquant que la notification et le consentement ne sont pas requis pour chaque utilisation de la technologie, mais seulement dans les situations où le rôle de l’IA est significatif pour les soins du patient..

- Consentement : outre la notification, le consentement doit être obtenu le cas échéant, bien que les directives laissent à la discrétion de l'organisme de soins de santé les détails de ce consentement..

Tableau récapitulatif

| Exigence | Conditions de notification |

|---|---|

| Informer les patients | Quand l'IA a un impact direct sur les soins |

| Obtenir le consentement | Le cas échéant et lorsque cela |

Conclusion

Les patients doivent être informés de l’utilisation de l’IA lorsque celle-ci a un impact direct sur leurs soins, et leur consentement doit être recueilli le cas échéant. Les recommandations laissent aux établissements de santé le soin d’interpréter les termes « approprié » et « pertinent », les obligeant à établir des politiques claires pour ces situations.

TROIS INFOGRAPHIES GÉNÉRÉES PAR NOTEBOOKLM

« Ce cours vise à doter les professionnels de santé d'une compréhension approfondie des systèmes de prise de décision algorithmique liés à l'IA. Les participants analyseront l'impact de l'IA sur les résultats pour les patients, évalueront son efficacité par rapport aux soins standards et appréhenderont la rigueur méthodologique de la recherche en IA.

La formation mettra en lumière les avantages et les risques potentiels de l'IA à travers les différentes spécialités médicales, tout en promouvant la transparence et les considérations éthiques dans la pratique clinique. À l'issue de ce programme, les professionnels de santé seront mieux préparés à intégrer les technologies d'IA de manière éthique et efficace dans les soins aux patients. » Coursebox/IA

🏥 IA Responsable en Médecine BY IA CLAUDE

🎯 Recommandations Clés

Gouvernance IA

Établir des comités multidisciplinaires avec représentation de la direction, IT, conformité, cliniciens, sécurité et confidentialité.

- Superviser la sélection et le cycle de vie des outils IA

- Rapporter les activités au conseil d'administration

Validation Locale

Valider les modèles sur les données et workflows locaux avant déploiement.

- Tester sur des ensembles de données représentatifs

- Évaluer la performance sur la population locale

Surveillance Continue

Instituer une surveillance post-marché pour détecter la dérive, la dégradation des performances ou les biais.

- Mesurer précision, erreurs et événements indésirables

- Adapter la fréquence selon la proximité des soins

Sécurité des Données

Protéger les données avec chiffrement, contrôles d'accès stricts et audits réguliers.

- Conformité HIPAA et lois des États

- Plan de réponse aux incidents

Transparence Patient

Informer et éduquer les patients sur l'utilisation de l'IA affectant leurs soins.

- Obtenir le consentement lorsque pertinent

- Divulgation appropriée selon le contexte

Évaluation des Biais

Identifier, documenter et atténuer les risques et biais avant et après déploiement.

- Audits réguliers des biais

- Demander les données de biais aux fournisseurs

Signalement Volontaire

Implémenter des rapports confidentiels et anonymisés des événements de sécurité IA.

- Intégrer aux systèmes de sécurité existants

- Signalement à des entités indépendantes

Formation

Fournir une formation spécifique au rôle pour les cliniciens et le personnel.

- Documentation complète pour chaque outil

- Guidance pratique d'utilisation

📈 État Actuel de l'Adoption

⚠️ Défis d'Implémentation

💰 Ressources Limitées

Les petits hôpitaux communautaires et ruraux manquent souvent d'expertise et de ressources pour effectuer des audits de biais indépendants et des analyses de risques approfondies.

🔄 Investissements Requis

La conformité nécessite des structures de gouvernance, tableaux de bord de surveillance, mécanismes de signalement d'incidents et documentation extensive.

🏗️ Fragmentation Système

Chaque hôpital doit effectuer ce travail indépendamment, créant des inefficacités et élargissant les disparités en matière de sécurité et de qualité.

⚖️ Responsabilité Légale

Les directives influencent les normes de responsabilité, mais les hôpitaux sont confrontés à un dilemme s'ils ne peuvent pas se conformer aux directives exigeantes.

L'Avenir de la Réglementation IA

Ces directives visent à améliorer la sécurité des patients, les résultats cliniques, la protection des données, la confiance et l'efficacité opérationnelle. Cependant, sans système unifié d'évaluation des produits IA, les hôpitaux continueront à assumer des responsabilités fragmentées. La FDA explore de nouvelles approches pour mesurer et évaluer la performance des dispositifs médicaux activés par l'IA dans des conditions réelles.

Source: Palmieri S, Robertson CT, Cohen IG. New Guidance on Responsible Use of AI. JAMA. 2026;335(3):207-208.

Publié en ligne : 3 décembre 2025 | doi:10.1001/jama.2025.23059

Infographie créée à partir de l'article JAMA • Janvier 2026

Commentaire

INFORMER le patient en cas d'utilisation en médecine d'une IA. Cette recommandation est plus que banale car nous devons systématiquement informer les patients sur le diagnostic, sur le traitement et sur le suivi. Cela reste la base de l'exercice médical avec ou sans IA. L'IA ne doit pas transgresser la déontologie médicale.

A LIRE ++++, TOP !

(ouvre dans un nouvel onglet)

(ouvre dans un nouvel onglet)