" L’IA Act n’entrave aucunement la révolution en mouvement de l’intelligence artificielle " Thierry Breton

"La souveraineté, c’est le sceptre, et la cyber, l'épée." Bertrand Leblanc-Barbedienne

-

"L’IA sans conscience n’est que ruine de l’intelligence humaine"Sylvain Montmory, inspiré de Rabelais

Galea S. Inaction sur la réglementation de l'intelligence artificielle en période de bouleversements. Forum Santé JAMA. 2025 ; 6(7) : e251246. doi :10.1001/jamahealthforum.2025.1246

https://jamanetwork.com/journals/jama-health-forum/fullarticle/2836054

Article libre d'accès

Nous vivons une époque déroutante.

En ce quart de siècle, plusieurs forces ont conspiré pour transformer de nombreux secteurs d'activité, notre quotidien et, ce qui nous intéresse particulièrement ici, les conditions et les structures qui déterminent la santé des individus et des populations.

Rien n'a peut-être été aussi disruptif que l'arrivée de l'intelligence artificielle (IA) largement disponible.

Bien que la recherche sur l'IA soit menée depuis des décennies et qu'elle soit utilisée de manière spécialisée depuis des années, l' introduction de ChatGPT (OpenAI) en 2022, premier chatbot à grand modèle de langage largement disponible, a radicalement transformé la conscience mondiale du potentiel de cette technologie et a ouvert la voie à l'adoption d'approches d'IA dans tous les secteurs, y compris ceux liés à la santé et aux soins de santé.

La rapidité avec laquelle l'IA a pénétré la conscience nationale et mondiale et, plus concrètement, intégré des algorithmes qui informent un large éventail de systèmes et de structures signifie, sans surprise, que les politiques et la surveillance ont pris du retard sur la mise en œuvre et l'adaptation de l'IA dans plusieurs secteurs.

C'est le cas pour la santé et les soins de santé.

Bien que des mesures aient été prises pour réglementer les algorithmes d'IA dans le secteur de la santé, notamment la publication par le Center for Medicare & Medicaid Services (CMS) des États-Unis d'une règle finale en 2024 sur la nécessité de l'intervention humaine pour prendre la décision médicale finale dans les régimes Medicare Advantage, l'évolution de la technologie a dépassé la surveillance réglementaire et de gouvernance, et l'élaboration de règles et de normes est bien en retard sur le rythme du développement technologique dans ce domaine.

Bien que les dangers potentiels de l'IA, tant dans le domaine de la santé au sens large que dans la pratique médicale plus spécifiquement, aient été abordés dans de nombreux articles et rapports, il faudra longtemps avant que nous puissions harmoniser l'ensemble des politiques et des règles nécessaires pour garantir que nous puissions maximiser les avantages potentiels de l'IA tout en minimisant les dommages.

L'émergence du second mandat de Donald J. Trump a aggravé ce défi de réglementation lacunaire.

Depuis le début de ce second mandat, une vague de décrets et de tentatives de modification des structures réglementaires et de gouvernance a été déclenchée.

Ces mesures se sont accompagnées de fréquents revirements et contre-mandats de règles récemment mises en œuvre, ce qui a perturbé – et, à bien des égards, paralysé – le paysage réglementaire dans de nombreux secteurs.

Ce changement déstabilisant s'est accompagné d'un effort fédéral concerté de réduction des coûts, notamment par des diminutions d'effectifs dans les agences fédérales. Nombre d'entre elles, déjà sous-équipées pour faire face au rythme des changements dans tous les secteurs, laissent ainsi encore moins bien placées pour aborder l'ampleur des politiques nécessaires à l'orientation des technologies émergentes comme l'IA.

Il a été largement souligné que cette période représente une menace considérable pour le pays et le monde, avec de nombreuses conséquences potentielles.

Cependant, une grande partie de notre réflexion s'est jusqu'à présent concentrée, à juste titre, sur les conséquences de l'action. Il convient également de réfléchir aux conséquences de l’inaction et, en l’occurrence, de l’inaction provoquée par le manque de personnel des agences fédérales, en particulier au sein du département de la Santé et des Services sociaux des États-Unis et dans les différentes unités – la Food and Drug Administration, les CMS, les Centres pour le contrôle et la prévention des maladies – qui ont un rôle à jouer dans la création des garde-fous qui peuvent garantir que les utilisations de l’IA sont positives.

Deux observations méritent réflexion.

Premièrement, l'évolution technologique est porteuse d'améliorations potentielles pour de nombreux aspects de l'expérience humaine. C'est le cas depuis longtemps et, nous l'espérons, cela continuera d'être le cas, l'IA étant au cœur de cette évolution.

Deuxièmement, le développement technologique présente également des risques potentiels, et la réglementation et la gouvernance ne peuvent être laissées exclusivement aux mains du secteur privé, animé par la recherche du profit.

Cette observation souligne la nécessité d'un secteur public actif et engagé, fonctionnant à un niveau capable de suivre la rapidité du changement et de l'adoption de nouvelles technologies comme l'IA.

Plusieurs autres régions du monde, notamment l'Europe, ont devancé les États-Unis dans ce domaine réglementaire, offrant ainsi un exemple potentiel de la manière dont les États-Unis peuvent s'engager de la même manière.

Nous ne pouvons qu'espérer que le gouvernement fédéral américain pourra reprendre cette fonction rapidement et s'engager autour de l'IA afin d'optimiser le potentiel de cette technologie encore nouvelle et d'en atténuer les risques potentiels.

À lire et relire

La loi européenne sur l'intelligence artificielle

Développements et analyses actualisés de la loi européenne sur l'IA

https://artificialintelligenceact.eu/ai-act-explorer/

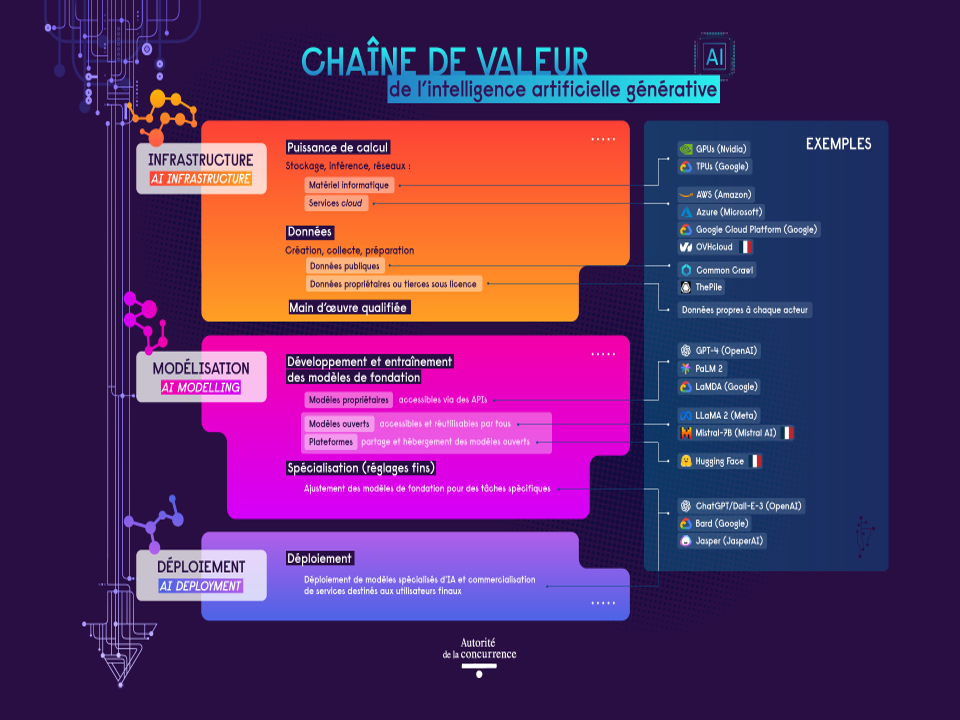

https://www.autoritedelaconcurrence.fr/fr/communiques-de-presse/intelligence-artificielle-generative-lautorite-sautosaisit-pour-avis-et-lance

Tableau 1 : Cinq résolutions européennes récentes sur l’IA

https://management-datascience.org/articles/18515/

Intelligence artificielle : le cadre juridique européen de l'IA en sept questions

Le règlement européen sur l'intelligence artificielle (IA) du 13 juin 2024 est paru au Journal officiel de l'Union européenne du 12 juillet. Le Conseil de l'Europe a adopté le 17 mai 2024 un traité international visant à garantir une IA respectueuse des droits fondamentaux.

Le règlement (UE) 2024/1689 du Parlement européen et du Conseil du 13 juin 2024 établissant des règles harmonisées concernant l'intelligence artificielle, premier acte législatif sur l'intelligence artificielle (IA), est paru au Journal officiel de l'Union européenne (JOUE) du 12 juillet 2024.

Le texte a été adopté par 523 votes pour, 46 contre et 49 abstentions au Parlement européen le 13 mars 2024.

Ce cadre réglementaire de l'IA poursuit les objectifs suivants :

- veiller à ce que les systèmes d’IA mis sur le marché soient sûrs et respectent la législation en vigueur en matière de droits fondamentaux, les valeurs de l’UE, l'État de droit et la durabilité environnementale ;

- * promouvoir l'adoption d'une IA axée sur l'humain et digne de confiance ;

- * garantir un cadre juridique uniforme afin de faciliter les investissements et l’innovation ;

- * renforcer la gouvernance et l’application effective de la législation existante en matière d'exigences de sécurité applicables aux systèmes d’IA et de droits fondamentaux ;

- * améliorer le fonctionnement du marché intérieur pour des applications d’IA légales et sûres, et * empêcher la fragmentation du marché.

Plus spécifiquement, le règlement établit :

- * des règles harmonisées concernant la mise sur le marché, la mise en service et l'utilisation de systèmes d'IA dans l'UE ;

- * l'interdiction de certaines pratiques ;

- - des exigences spécifiques applicables aux systèmes d'IA à haut risque ;

- - des règles harmonisées en matière de transparence applicables :

- - aux systèmes d'IA destinés à interagir avec des personnes,

- - aux systèmes de reconnaissance des émotions et de catégorisation biométrique,

- - aux systèmes d'IA générative utilisés pour générer ou manipuler des images ou des contenus audio ou vidéo ;

- - des mesures visant à soutenir l'innovation, particulièrement pour les petites et moyennes entreprises (PME).

Cette approche doit tenir compte des résultats bénéfiques sur les plans sociaux et environnementaux que peut apporter l'IA, mais aussi des nouveaux risques ou des conséquences négatives que peut engendrer cette technologie.

La cohérence est assurée avec la Charte des droits fondamentaux de l'UE, mais aussi avec le droit dérivé de l'UE en matière de protection des données, de protection des consommateurs, de non-discrimination et d'égalité entre les femmes et les hommes. Le règlement complète le droit existant en matière de non-discrimination en prévoyant des exigences qui visent à réduire au minimum le risque de discrimination algorithmique, assorties d’obligations concernant les essais, la gestion des risques, la documentation et le contrôle humain tout au long du cycle de vie des systèmes d’IA.

Le règlement sur l'IA sera pleinement applicable à partir du 2 août 2026.

Afin de garantir la sécurité juridique, de faciliter la convergence internationale et une large acceptation, tout en offrant la souplesse nécessaire à la prise en compte des évolutions technologiques rapides de ce domaine, la notion de "système d'IA" est définie par le règlement. Elle est alignée sur les travaux des organisations internationales qui œuvrent dans ce domaine.

Une des caractéristiques essentielles des systèmes d'IA est leur capacité d'inférence, que le règlement définit comme "le processus consistant à générer des sorties telles que des prédictions, du contenu, des recommandations ou des décisions, qui peuvent influencer l’environnement physique ou virtuel, et la capacité des systèmes d’IA à inférer des modèles ou des algorithmes, ou les deux, à partir d’entrées ou de données".

Les techniques qui permettent l'inférence lors de la construction d'un système d'IA comprennent :

- * des approches d’apprentissage automatique, qui apprennent à partir des données la manière d’atteindre certains objectifs ;

- * des approches fondées sur la logique et les connaissances qui font des inférences à partir * des connaissances encodées ou de la représentation symbolique de la tâche à résoudre.

Ces techniques vont au-delà du traitement de données de base en ce que la capacité d'inférence d'un système d'IA lui permet l'apprentissage, le raisonnement ou la modélisation.

Les systèmes d'IA étant conçus pour fonctionner à différents niveaux d'autonomie, ils bénéficient d'un certain degré d'indépendance dans leur action par rapport à une ingérence humaine et de capacités à fonctionner sans intervention humaine.

Le règlement sur l'IA définit aussi :

- un système d'identification biométrique à distance comme "un système d’IA destiné à identifier des personnes physiques sans leur participation active, généralement à distance, en comparant les données biométriques d’une personne avec celles qui figurent dans une base de données" ;

- un système d’identification biométrique à distance en temps réel comme "un système d’identification biométrique à distance dans lequel l’acquisition des données biométriques, la comparaison et l’identification se déroulent sans décalage temporel important et qui comprend non seulement l’identification instantanée, mais aussi avec un léger décalage afin d'éviter tout contournement des règles".

Le règlement sur l'IA interdit les pratiques suivantes en matière d'intelligence artificielle :

- système d'IA ayant recours à des techniques subliminales au-dessous du seuil de conscience d'une personne pour altérer substantiellement son comportement et de manière à causer un préjudice physique ou psychologique (manipulation du comportement humain pour contourner le libre arbitre) ;

- * système d'IA exploitant les éventuelles vulnérabilités dues à l'âge ou au handicap d'un individu pour altérer substantiellement son comportement et de manière à causer un préjudice physique ou psychologique ;

- * systèmes d'IA destinés à évaluer ou à établir un classement de la fiabilité de personnes en fonction de leur comportement social ou de caractéristiques personnelles et pouvant entraîner * un traitement préjudiciable de personnes, dans certains contextes, injustifié ou disproportionné.

L'accord trouvé entre le Parlement et les États membres précise l'interdiction des systèmes de catégorisation biométrique utilisant des caractéristiques sensibles (opinions politiques, religieuses, philosophiques, orientation sexuelle…) et la notation sociale basée sur le comportement social ou les caractéristiques personnelles ; - * systèmes d’IA pour mener des évaluations des risques des personnes physiques visant à évaluer ou à prédire le risque qu’une personne physique commette une infraction pénale, uniquement * sur la base du profilage d’une personne physique ou de l’évaluation de ses traits de personnalité ou caractéristiques.

Cette interdiction ne s’applique pas aux systèmes d’IA utilisés pour étayer l’évaluation humaine de l’implication d’une personne dans une activité criminelle ; - * systèmes d’IA créant ou développant des bases de données de reconnaissance faciale par le moissonnage non ciblé d’images faciales provenant d’internet ou de la vidéosurveillance ;

- * reconnaissance des émotions sur le lieu de travail et les établissements d'enseignement, sauf pour des raisons médicales ou de sécurité ;

- * systèmes d'identification biométrique à distance en temps réel dans des espaces accessibles au public à des fins répressives, sauf dans les cas suivants :

- * ciblée de victimes potentielles spécifiques de la criminalité (enfants disparus, traite, exploitation sexuelle),

- * prévention d'une menace spécifique, substantielle et imminente pour la vie ou la sécurité des personnes ou la prévention d'une attaque terroriste,

- Il s'agit de l'identification, de la localisation ou de la poursuite des auteurs ou des suspects de certaines infractions pénales, qui sont punissables d'une peine d'une durée maximale d'au moins quatre ans.

L'utilisation de systèmes d'identification biométriques à distance en temps réel doit :

- * tenir compte de la situation donnant lieu au recours au système et de la gravité ou de l'ampleur du préjudice en l'absence de son utilisation ;

- * tenir compte des conséquences sur les droits et libertés de toutes les personnes concernées (gravité, probabilité, ampleur) ;

- * être subordonnée à une autorisation préalable octroyée par une autorité judiciaire ou administrative compétente.

L'annexe III du règlement dresse une liste des systèmes d'IA à haut risque. Les eurodéputés ont inclus dans le règlement une analyse d'impact obligatoire sur les droits fondamentaux, également applicable au secteur bancaire et des assurances. Les systèmes d'IA utilisés pour influer sur le résultat d'élections et le comportement des électeurs sont classés à haut risque.

Les citoyens auront le droit de :

- * déposer des plaintes concernant les systèmes d'IA ;

- – recevoir des explications sur les décisions fondées sur des systèmes d'IA à haut risque ayant une incidence sur leurs droits.

Le non-respect des règles pourra entraîner des amendes pouvant aller jusqu'à 35 millions d'euros ou 7% du CA mondial, en fonction de la taille de l'entreprise et de l'infraction.

Le 4 février 2025, la Commission a publié les lignes directrices sur les pratiques interdites en matière d'IA telles qu'elle sont définies par le règlement. Elles donnent un aperçu des pratiques d'IA jugées inacceptables en raison de leurs risques potentiels pour les valeurs européennes et les droits fondamentaux. Ces lignes directrices visent à aider les parties prenantes à comprendre la législation sur l'IA et à garantir une application cohérente et uniforme dans toute l'UE :

- * des interprétations, non contraignantes, sur l'interprétation des interdictions par la Commission ;

- * des explications juridiques ;

- * des exemples pratiques.

Selon l'article 77 du règlement sur l'IA, chaque État membre doit identifier les autorités ou organismes publics nationaux qui supervisent ou font respecter les obligations au titre du droit de l’Union visant à protéger les droits fondamentaux, y compris le droit à la non-discrimination, en ce qui concerne l’utilisation des systèmes d’IA à haut risque visés à l'annexe III dudit règlement.

Les autorités françaises identifiées sont :

- * la Direction générale de la concurrence, de la consommation et de la répression des fraudes (DGCCRF) ;

- * la Commission nationale de l’informatique et des libertés (CNIL) ;

- * le Défenseur des droits.

Cette liste pourra être complétée.

Les systèmes d’intelligence artificielle connaissent une évolution rapide qui nécessite la mise en place de nouvelles formes de contrôle réglementaire et d’un espace sûr pour l’expérimentation. Le règlement doit garantir une innovation responsable et l’intégration de garanties et de mesures d’atténuation des risques appropriées. Pour garantir un cadre juridique propice à l’innovation, les États membres devront mettre en place des "bacs à sable réglementaires" sur l'IA pour faciliter l'innovation sous un contrôle réglementaire strict avant la mise sur le marché ou en service de ces systèmes.

L'objectif est :

- * de favoriser l’innovation en créant un environnement contrôlé d’expérimentation au stade * du développement afin d'assurer la conformité des systèmes d’IA innovants avec le règlement ;

- *de renforcer la sécurité juridique pour les innovateurs ainsi que le contrôle et la compréhension des possibilités, des risques émergents et des conséquences de l’utilisation de l’IA ;

- * d’accélérer l’accès aux marchés en supprimant les obstacles pour les PME et les jeunes entreprises.

L'UE n'a pas attendu le règlement sur l'IA du 13 juin 2024 pour s'intéresser à cette question et à ses enjeux.

En 2017, le Conseil européen souligne la nécessité de faire preuve d'un sens de l'urgence face aux tendances émergentes, notamment l'IA [Réunion du Conseil européen (19 octobre 2017) – conclusions].

En 2018, la Commission présente un premier plan coordonné sur l'intelligence artificielle (communication de la Commission). Il s'agit d'un engagement commun visant à renforcer le potentiel européen pour être compétitif à l'échelle mondiale, notamment au travers de stratégies nationales des États membres.

Dans ses conclusions de 2019 sur le plan coordonné, le Conseil de l'UE souligne la nécessité d'assurer le respect intégral des droits des citoyens européens. Le Conseil demande que la législation en vigueur fasse l'objet d'un réexamen. [Intelligence artificielle b) Conclusions sur le plan coordonné dans le domaine de l'intelligence artificielle - Adoption].

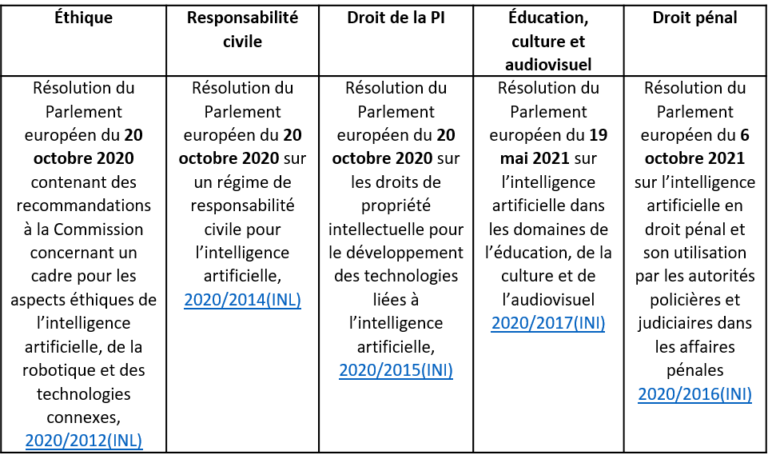

Le Parlement européen a travaillé sur plusieurs résolutions relatives à l'IA dans divers domaines :

- * aspects éthiques [2020/2012 (INL)] ;

- * régime de responsabilité civile (résolution du Parlement européen du 20 octobre 2020) ;

- * droits de propriété intellectuelle (résolution du Parlement européen du 20 octobre 2020) ;

- *droit pénal et son utilisation par les autorités policières et judiciaires dans les affaires pénales [2020/2016(INI)] ;

- *éducation, culture et audiovisuel [2020/2017(INI)].

Ces textes contiennent des recommandations à destination de la Commission, mais aussi des propositions législatives sur les différents thèmes abordés.

Le 19 février 2020, la Commission publie un Livre blanc sur l'intelligence artificielle qui réaffirme le double objectif européen de promouvoir l'adoption de l'IA et de tenir compte des risques associés à certaines utilisations de cette technologie.

En 2020, le Conseil européen demande à la Commission de "présenter une définition claire et objective des systèmes d'intelligence artificielle à haut risque" [Réunion extraordinaire du Conseil européen (1er et 2 octobre 2020) - conclusions].

Dans des conclusions publiées en octobre 2020, le Conseil de l'UE rappelle que "si les technologies numériques, y compris l'IA, présentent de plus en plus d'opportunités et d'avantages, leur conception, leur développement, leur déploiement et leur utilisation abusive pourraient aussi comporter des risques pour les droits fondamentaux, la démocratie et l'État de droit" [Conclusions de la présidence – La charte des droits fondamentaux dans le contexte de l’intelligence artificielle et du changement numérique].

En avril 2021, la Commission présente des mesures sur l'IA :

- * sur la promotion d'une approche européenne ;

- * un réexamen du plan coordonné en matière d'intelligence artificielle ;

- * une proposition de cadre réglementaire sur l'IA et une analyse d'impact.

Que dit la Cour des comptes européenne ?

Un rapport de la Cour des comptes européenne de mai 2024 analyse l'écosystème européen d'IA :

- Les investissements européens dans l'IA n'ont pas suivi le rythme dicté par les leaders mondiaux ;

- Les projets dans le domaine de l'IA financés par l'UE ne font pas l'objet d'un suivi systématique ;

- la coordination entre l'UE et les États membres est inefficace, faute d'outils de gouvernance.

Selon le responsable de l'audit, "dans la course à l’IA, il y a fort à parier que le gagnant raflera toute la mise. Si l'UE veut gagner son pari, la Commission européenne et les États membres doivent unir leurs forces de manière plus efficace, accélérer la cadence et libérer le potentiel de l'Union pour réussir cette révolution technologique majeure qui est en cours."

Le 17 mai 2024, le Conseil de l'Europe a adopté la convention-cadre sur l'intelligence artificielle et les droits de l'homme, la démocratie et l'État de droit. Il s'agit d'un traité international, adopté par les ministres des affaires étrangères des 46 pays membres du Conseil de l'Europe.

Cette convention-cadre est le premier texte d'ampleur internationale juridiquement contraignant dans le domaine de l'IA. Ses dispositions devront être transposées dans le droit national des États signataires.

Le texte vise à garantir une IA respectueuse des droits fondamentaux, entre autres face aux risques :

- *de pratiques discriminatoires ;

- * de remise en cause des processus démocratiques ;

- *d'atteinte à la vie privée ;

- *d'utilisation de l'IA par certains États à des fins répressives.

LLa convention-cadre établit des règles relatives au respect des droits fondamentaux à toutes les étapes du cycle de vie des systèmes d'IA.

La convention-cadre est un traité international incluant les États membres de l'UE, mais aussi onze États non membres, dont les États-Unis, le Japon et le Canada. Ce texte est compatible avec le règlement sur l'IA de l'UE qui concerne plus spécifiquement l'Union européenne.

La convention-cadre permet ainsi d'être un texte juridiquement contraignant pour des signataires hors UE parmi les acteurs majeurs dans la recherche et le développement des systèmes d'IA.

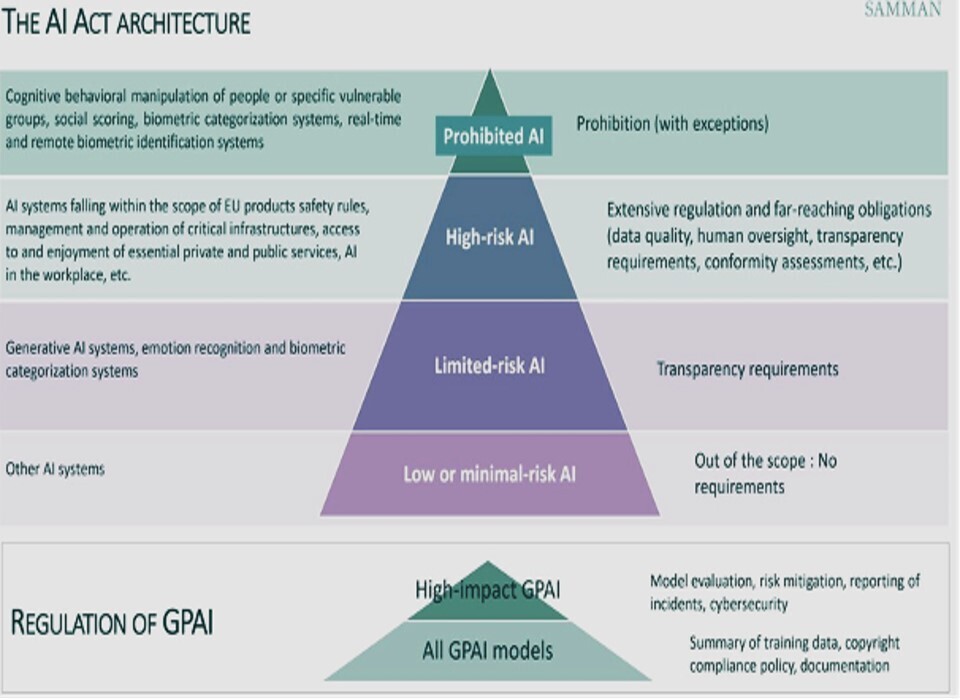

The four risk levels for AI systems.

Systèmes d’IA à risque inacceptable :

Ces systèmes sont considérés comme une menace pour les individus. Il peut s’agir de ceux qui utilisent la manipulation inconsciente, l’exploitation des vulnérabilités humaines, la notation sociale, l’identification biométrique et la catégorisation biométrique (origine ethnique, religion, etc.)

Ces systèmes sont interdits, y compris dans le cas de l’identification biométrique à distance en temps réel dans des espaces publics comme la reconnaissance faciale, sauf dans des conditions strictes particulières d’application de la loi qui doivent d’abord être approuvées par un tribunal.

Systèmes d’IA à haut risque :

Ce sont des systèmes ayant un impact sur la sécurité ou les droits fondamentaux, y compris l’IA dans les jouets, les dispositifs médicaux, les infrastructures critiques, l'éducation, la formation professionnelle, l’emploi, les services privés essentiels (crédit bancaire, assurance), l’application de la loi, la migration et l'interprétation juridique, l’accès aux prestations publiques essentielles (santé, appels d’urgence, justice).

Ces systèmes doivent être enregistrés dans une base de données de l’UE, faire l’objet d’une évaluation approfondie des risques et faire l’objet de rapports réguliers afin de garantir une conformité et une surveillance strictes. Une évaluation devra être effectuée avant la mise sur le marché des systèmes d’IA à haut risque, puis tout au long de leur cycle de vie.

Systèmes d’IA à risque limité :

Cette catégorie comprend les modèles d’IA générative. Bien qu’ils ne soient pas à haut risque en soi, ils doivent répondre à des exigences de transparence et respecter la législation européenne sur le droit d’auteur.

Les fournisseurs de modèles et d’applications d’IA à risque limité doivent informer les utilisateurs que leur contenu est généré par l’IA, empêcher la génération de contenu illégal et publier des résumés des données protégées par des droits d’auteur.

Les modèles d’IA à fort impact, i.e., ayant des capacités égales ou supérieures aux capacités des modèles d’IA à usage général les plus avancés, doivent faire l’objet d’évaluations approfondies et signaler les incidents graves à la Commission européenne. Le contenu généré ou modifié par l’IA (par exemple, les deepfakes) doit être clairement identifié comme tel.

Système d’IA à risque minimal :

Il s’agit, par exemple, des filtres antispam, des jeux vidéo basés sur l’IA et des systèmes de gestion des stocks.

La plupart des systèmes d’IA de cette catégorie ne sont soumis à aucune obligation en vertu de la loi sur l’IA, mais les entreprises peuvent adopter volontairement des codes de conduite supplémentaires. La responsabilité principale incombera aux « fournisseurs » de systèmes d’IA, bien que toute entreprise qui les utilise doive rester vigilante quant à ses obligations de conformité.

Cas particulier des IA à usage général

Les développeurs doivent fournir un résumé détaillé des jeux de données d’entraînement, notamment pour s’assurer du bon respect des droits d’auteur, des instructions d’utilisation, ainsi qu’une documentation technique (définie par l’annexe IV du RIA) qui contient les informations nécessaires pour démontrer que le système est conforme au RIA. Elle doit être préparée avant la mise sur le marché ou la mise en service du système.

Les obligations de documentation technique ne s’appliquent pas aux fournisseurs de modèles d’IA à usage général qui sont publiés dans le cadre d’une licence libre et ouverte permettant de consulter, d’utiliser, de modifier et de distribuer le modèle, et dont les paramètres (poids, informations sur l’architecture du modèle, informations sur l’utilisation du modèle) sont rendus publics.

Dans la mesure où les systèmes d’IA à usage général peuvent être utilisés comme des systèmes d’IA à haut risque en tant que tels ou comme des composants d’autres systèmes d’IA à haut risque, une coopération avec les fournisseurs des systèmes d’IA à haut risque concernés est requise afin de leur permettre de se conformer à leurs obligations.

Dans le cas particulier des IA à usage général présentant un risque systémique – c'est-à-dire ayant une incidence significative en raison de leur portée ou d’effets négatifs réels ou raisonnablement prévisibles sur la santé publique, la sûreté, la sécurité publique, les droits fondamentaux ou la société dans son ensemble, pouvant être propagés à grande échelle tout au long de la chaîne de valeur, par ex, ayant une puissance de calcul supérieure à 10 puissance 25 flops- s'ajoutent aux exigences de transparence des exigences d'évaluation et de tests, d’atténuation des risques, de déclaration des incidents sérieux, de cybersécurité et d’analyse de la consommation d'énergie.

Exemptions.

Le RIA ne s’applique pas aux systèmes d’IA -qu’ils soient mis ou non sur le marché– lorsqu’ils sont mis en service ou utilisés exclusivement à des fins militaires, de défense ou de sécurité nationale, quel que soit le type d’entité exerçant ces activités.

Le RIA ne s’applique pas aux systèmes d’IA spécifiquement développés et mis en service uniquement à des fins de recherche et développement scientifiques, ni à leurs sorties.

Les déployeurs qui sont des personnes physiques utilisant des systèmes d’IA dans le cadre d’une activité strictement personnelle, à caractère non professionnel, sont exemptés.

Enfin, les systèmes d’IA mis à disposition sous forme de licence libre ou ouverte -sauf s’il s’agit de systèmes d’IA à haut risque, s’ils relèvent d’utilisations interdites ou d’obligations de transparence (en raison de leur usage selon l’article 50)- sont exemptés.

https://www.village-justice.com/articles/act-nouveau-cadre-juridique-europeen-pour-une-intelligence-artificielle-ethique,53595.htmlLa sagesse de l'EUROPE vis-à-vis de l'IA, la désorganisation de l'IA aux USA. Cet IA-ACT européen est un acte majeur , la planète devrait s'en inspirer. Il était absolument nécessaire de légiférer au niveau européen sur l'IA afin d'éviter tous les dérapages , quis sont déjà nombreux. Si on veut que l'IA intègre notre civilisation, il faut la maîtriser, l'IA-ACT EUROPEEN est la réponse adéquate. Notons qu'en matière de santé, c'était et c'est un préalable obligatoire. Les USA doivent réagir dans le même sens , mais est-ce qu'avec TRUMP , cela reste t-il du domaine du possible ?

Si la réponse est NON, on court à la catastrophe...

Le problème de TRUMP et de l'IA, c'est son incompétence totale sur cette thématique comme pour les autres.

IA-ACT : la France a beaucoup œuvré dans sa rédaction , saluons le travail réalisé par Thierry BRETON.

Copyright : Dr Jean Pierre Laroche /2025