"L'intelligence artificielle est un domaine en constante évolution qui suscite à la fois l'excitation et les questionnements. Il est essentiel de reconnaître les limites actuelles de l'IA et de rester vigilant quant à son développement futur. L'objectif devrait être de créer une IA qui soit un outil pour l'humanité, favorisant notre compréhension du monde plutôt que de nous rendre dépendants de machines incompréhensibles."« Certaines personnes craignent que l’intelligence artificielle nous fasse nous sentir inférieurs, mais toute personne saine d’esprit devrait avoir un complexe d’infériorité chaque fois qu’elle regarde une fleur. » Alan Kay

https://www.toolify.ai/fr/ai-new-fr/15-citations-clbres-sur-lintelligence-artificielle-qui-vous-feront-rflchir-2597083

Guni A, Whiting P, Darzi A, Ashrafian H. The next generation of evidence synthesis for diagnostic accuracy studies in artificial intelligence.

La prochaine génération de synthèse de données probantes pour les études de précision diagnostique en intelligence artificielle

https://www.thelancet.com/journals/landig/article/PIIS2589-7500(24)00115-8/fulltext

Article libre d'accès

Des résultats prometteurs ont également été démontrés dans d’autres essais de grande envergure, comme un essai évaluant l’utilisation de l’IA dans l’interprétation de l’électrocardiogramme.

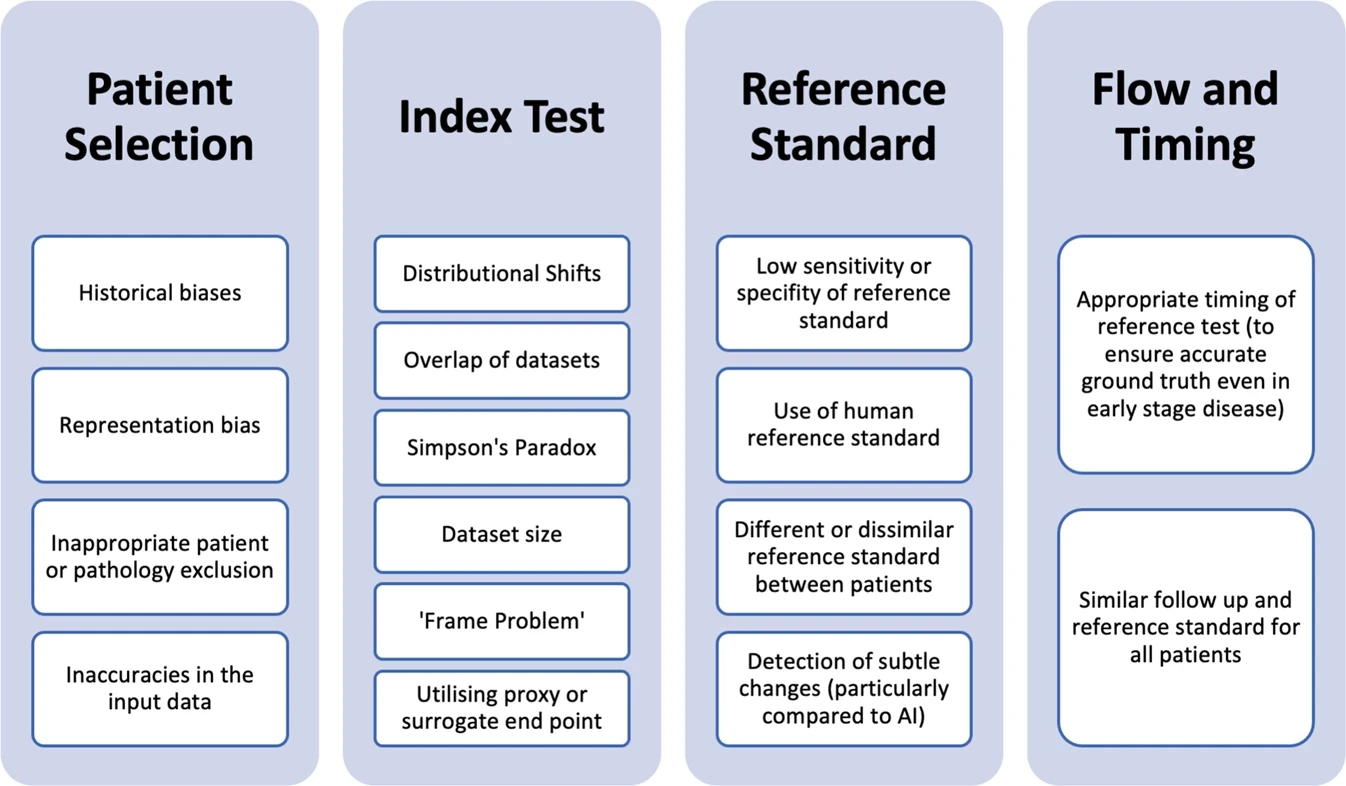

Nous avons précédemment décrit les biais potentiels pertinents pour les études de précision diagnostique de l’IA, notamment l’utilisation de référentiels open source à grande échelle ; le manque de validation externe des tests d’index et l’explication inadéquate de leur formation, des détails algorithmiques et des ensembles de tests ; l’utilisation de normes de référence inappropriées et incohérentes ; et le manque de clarté des rapports sur le calendrier entre les tests d’index et les normes de référence.

Pour simplifier l’autorisation des dispositifs cliniquement utiles, la majorité des approbations récentes de dispositifs d’IA par la FDA ont été effectuées via la voie 510(k), qui facilite l’autorisation si les dispositifs sont substantiellement similaires à un dispositif précédemment approuvé (appelé le prédicat). Par ailleurs, le cadre réglementaire proposé par la FDA pour les modifications des logiciels d’IA/d’apprentissage automatique en tant que dispositif médical

L'Agence de réglementation des médicaments et des produits de santé du Royaume-Uni et l'Agence européenne des médicaments n'ont pas encore produit de directives détaillées sur les cadres réglementaires des dispositifs de santé d'IA, mais visent globalement à favoriser l'innovation conformément aux États-Unis.

* l’utilisation de sources de données et d’ensembles d’entraînement distincts pour valider les algorithmes

* l’impact de la dérive des données qui dégrade la précision du modèle au fil du temps

* la reproduction et l’enracinement de biais existants qui peuvent être à l’échelle de la population et non représentatifs

* les différences d’applicabilité clinique, de mise en œuvre et d’interopérabilité.

Il est important de noter que cet outil sera développé grâce à un consensus international sur les principaux biais qui pourraient limiter la traduction dans les flux de travail cliniques. Le rôle de l'évaluation des preuves dans les diagnostics par IA reposera de plus en plus sur l'intégration de données provenant de multiples itérations d'un large éventail d'outils d'IA hétérogènes. Par la suite, le besoin d'une synthèse de preuves robuste et transparente au moyen d'outils tels que QUADAS-AI sera crucial pour la qualité, la sécurité et la valeur des outils de diagnostic clinique adoptés.

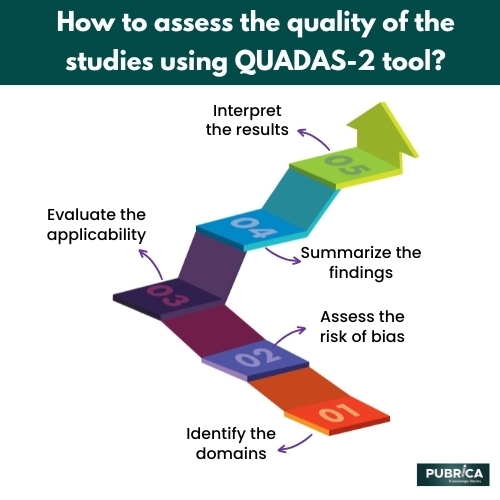

QUADAS-2

- Identifier les domaines : L' outil QUADAS-2 comprend quatre domaines :

* test d'index

* sélection des patients,

* norme de référence,

* flux et timing.

Les examinateurs doivent prendre en compte chaque domaine pour chaque étude incluse dans la revue systématique.

- Évaluer le risque de biais : les évaluateurs doivent évaluer le risque de biais pour chaque domaine à l’aide de questions de signalisation spécifiques à chaque domaine. Les questions de signalisation sont utilisées pour déterminer le risque de biais pour les domaines individuels comme « faible », « élevé » ou « peu clair ».

- Évaluer l’applicabilité : Les examinateurs doivent évaluer l’applicabilité des études en considérant si la population étudiée, le test d’index et la norme de référence sont similaires à la population, au test et à la norme d’intérêt dans la revue systématique.

- Résumer les résultats : Les évaluateurs doivent résumer les résultats des évaluations d’applicabilité et le risque de biais pour chaque étude et domaine.

- Interpréter les résultats : les examinateurs doivent interpréter les résultats de l’évaluation QUADAS-2 dans le contexte de la revue systématique. Cela peut impliquer d’identifier les études présentant un faible risque de biais et une applicabilité élevée et d’exclure les études présentant un risque élevé de biais ou une applicabilité peu claire.

L'outil QUADAS-2 peut être utilisé pour évaluer la qualité des études individuelles incluses dans une revue systématique des études sur l'exactitude diagnostique et pour identifier les sources d'hétérogénéité entre les études. L'outil a été validé et est largement utilisé dans les revues systématiques des études sur l'exactitude diagnostique.

https://pubrica.com/academy/meta-analysis/how-to-assess-the-quality-of-the-studies-using-the-quadas-2-tool/

QUADAS AI

Sounderajah, V., Ashrafian, H., Rose, S. et al. Un outil d'évaluation de la qualité pour les études de précision des tests diagnostiques centrées sur l'intelligence artificielle : QUADAS-AI. Nat Med 27 , 1663–1665 (2021). https://doi.org/10.1038/s41591-021-01517-0

Pour s’attaquer à ces sources de biais, ainsi qu’à des exemples spécifiques à l’IA tels que le biais algorithmique, nous proposons une extension spécifique à l’IA de QUADAS-2 et QUADAS-C https://doi.org/10.17605/OSF.IO/HQ8MF (2018)." data-track="click" data-track-action="reference anchor" data-track-label="link" data-test="citation-ref" aria-label="Référence 5">5 , un outil de risque de biais qui a été développé pour les études comparatives de précision. Ce nouvel outil, appelé QUADAS-AI, fournira aux chercheurs et aux décideurs politiques un cadre spécifique pour évaluer le risque de biais et l’applicabilité lors de la réalisation d’examens qui évaluent les DTA de l’IA et d’examens d’études comparatives de précision qui évaluent au moins un test d’indice centré sur l’IA.

QUADAS-AI viendra compléter les initiatives en cours en matière d’outils de lignes directrices pour la production de rapports, telles que STARD-AI 6 et TRIPOD-AI 7 . QUADAS-AI est coordonné par une équipe de projet mondiale et un comité directeur composé de cliniciens-chercheurs, d’informaticiens, d’épidémiologistes, de statisticiens, de rédacteurs de revues, de représentants du réseau EQUATOR https://www.equator-network.org/ (consulté le 27 septembre 2021)." data-track="click" data-track-action="reference anchor" data-track-label="link" data-test="citation-ref" aria-label="Référence 11">11 , de responsables de la réglementation, de chefs de file de l’industrie, de bailleurs de fonds, de décideurs politiques en matière de santé et de bioéthiciens. Compte tenu de la portée des technologies de l’IA, nous considérons que la mise en relation des parties prenantes mondiales est de la plus haute importance pour cette initiative.

Jayakumar, S., Sounderajah, V., Normahani, P. et al. Quality assessment standards in artificial intelligence diagnostic accuracy systematic reviews: a meta-research study. npj Digit. Med. 5, 11 (2022). https://doi.org/10.1038/s41746-021-00544-y Types de biais affectant la qualité et l’applicabilité des études de précision diagnostique basées sur l’intelligence artificielle.

Types de biais affectant la qualité et l’applicabilité des études de précision diagnostique basées sur l’intelligence artificielle.